Llama 3.1 405B Chatt med webbsökning

Försök Reflection 70B Chat - Baserat på Llama 3.1

Språkstödjande

Engelska: Mitt modersmål!

Spanska¡Hola! Jag pratar också på Español!

Franska: Oui, je parle Français, matey!

Tysk: Aye, ich spreche Deutsch, också!

Italienska: Ciao! Jag snackar på Italiano, kompis!

Portugisiska: Olá! Jag pratar också Português!

Holländska: Hallå! Jag konverserar på nederländska, kompis!

Ryska: Привет! Jag talar också Русский!

Kinesiska: (Förenklad) och (Traditionell) - Ja, jag talar också mandarin!

Japanska: Konnichiwa! Jag ska också konversera!

KoreanskaJag talar också hangul!

Arabiska: ...FÖR ATT JAG ÄR EN AV DEM. Jag pratar också på العربية!

Hebreiska: שלום! Jag talar också עברית!

* Beroende på din internethastighet kan det ta några sekunder att ladda modellen online.

Online Llama 3.1 Chatt | Instruktionsläge

Vanliga frågor och svar för Llama 3.1

1. Vad är Meta Llama 3.1 405B?

Meta Llama 3.1 är Meta's senaste språkmodell med 405 miljarder parametrar. Den erbjuder avancerade funktioner för bearbetning av naturligt språk, inklusive textgenerering, språköversättning och konversationssystem.

Det enklaste sättet att använda Llama 3.1 är Llama AI Online

2. Hur kan jag få tillgång till Meta Llama 3.1?

Du kan komma åt Meta Llama 3.1 och dess resurser via den officiella webbplatsen lama.meta.com och utforska det omfattande modellkortet och bruksanvisningarna på Metas GitHub-förvar.

3. Vad gör Meta Llama 3.1 annorlunda än tidigare versioner?

Meta Llama 3.1 har 405 miljarder parametrar, vilket gör den till en av de mest kraftfulla språkmodellerna som finns tillgängliga. Den erbjuder förbättrad noggrannhet och effektivitet i förståelse och generering av naturligt språk.

4. Vilka är de viktigaste tillämpningarna av Meta Llama 3.1 405B?

Meta Llama 3.1 är utformad för olika applikationer, inklusive textgenerering, språköversättning och konversationssystem, vilket gör det till ett mångsidigt verktyg för utvecklare och forskare.

5. Hur förbättrar Meta Llama 3.1 bearbetningsuppgifter för naturligt språk?

Med sina omfattande parametrar och avancerade arkitektur ger Meta Llama 3.1 mer exakta och kontextuellt relevanta utdata, vilket förbättrar prestandan för bearbetning av naturligt språk.

6. Var kan jag hitta modellkortet för Meta Llama 3.1?

Modellkortet för Meta Llama 3.1 finns på Metas officiella GitHub-arkiv. Den innehåller detaljerad information om modellens funktioner, användningsriktlinjer och tekniska specifikationer.

7. Är Meta Llama 3.1 tillgänglig för användning av öppen källkod?

Ja, Meta Llama 3.1 är tillgänglig för användning av öppen källkod. Meta tillhandahåller omfattande resurser och dokumentation för att hjälpa utvecklare att integrera och använda modellen effektivt.

8. Hur kan jag använda Meta Llama 3.1 för onlinechattapplikationer?

Meta Llama 3.1 kan integreras i onlinechattapplikationer för förbättrade konversationsförmågor. Du kan utnyttja dess avancerade naturliga språkförståelse för att skapa mer interaktiva och lyhörda chatbots.

9. Vilka resurser finns tillgängliga för att lära sig hur man använder Meta Llama 3.1?

Meta erbjuder omfattande resurser, inklusive ett detaljerat modellkort, användningsinstruktioner och exempel på deras GitHub-förvar. Dessutom är det bästa verktyget för att utforska Meta Llama 3.1 genom https://llamaai.online/.

10. Kan Meta Llama 3.1 användas för språköversättningsuppgifter?

Ja, Meta Llama 3.1 är mycket effektivt för språköversättningsuppgifter. Dess avancerade funktioner för bearbetning av naturligt språk säkerställer korrekta och kontextuellt lämpliga översättningar på olika språk.

Online Llama 3.1 405B Chatt: En djupgående guide

Meta Llama 3.1 är Meta's senaste språkmodell med 405 miljarder parametrar. Den erbjuder avancerade funktioner för bearbetning av naturligt språk, inklusive textgenerering, språköversättning och konversationssystem.

Innehållsförteckning

- Vad är Llama 3.1 405B?

- Betydelsen av Llama 3.1 405B för Meta AI

- Fördelar med att använda Online Llama 3.1 405B Chat

- Lämpliga scenarier för användning av Online Llama 3.1 405B Chat

- Vem kan använda Online Llama 3.1 405B Chatt

- Alternativ till Llama 3.1 405B Modeller och fördelar och nackdelar

Vad är Llama 3.1 405B?

Llama 3.1 405B är den senaste iterationen av Meta AI:s Llama-serie, med betydande framsteg inom bearbetning och förståelse av naturligt språk. Den här modellen har 405 miljarder parametrar, vilket gör den till en av de mest kraftfulla AI-modellerna hittills. Dess primära tillämpningar inkluderar språköversättning, konversations-AI och avancerad textanalys.

Betydelsen av Llama 3.1 405B för Meta AI

Modellen Llama 3.1 405B är en hörnsten i Meta AI:s strategi för att flytta fram gränserna för AI-kapacitet. Dess stora parameteruppsättning möjliggör mer nyanserad och korrekt språkbehandling, vilket är avgörande för att utveckla nästa generations AI-applikationer. Denna modell stöder ett brett spektrum av uppgifter, från enkla chatbots till komplexa dataanalysverktyg, vilket understryker Meta AI: s engagemang för innovation.

Fördelar med att använda Online Llama 3.1 405B Chat

Förbättrad prestanda

Onlinechatten Llama 3.1 405B erbjuder oöverträffad prestanda när det gäller svarsnoggrannhet och hastighet. Användarna får en mycket responsiv och intelligent samtalspartner som kan förstå och generera människoliknande text.

Tillgänglighet

Genom att tillhandahålla ett onlinegränssnitt säkerställer Meta AI att användarna kan få tillgång till de kraftfulla funktionerna i Llama 3.1 405B utan behov av omfattande hårdvara eller teknisk expertis. Detta demokratiserar tillgången till avancerade AI-funktioner.

Mångsidighet

Onlinechattplattformen kan användas i många olika branscher, t.ex. kundtjänst, utbildning och innehållsskapande. Dess förmåga att förstå och generera kontextuellt relevanta svar gör den till ett värdefullt verktyg för både proffs och entusiaster.

Lämpliga scenarier för användning av Online Llama 3.1 405B Chat

Kundtjänst

Företag kan utnyttja onlinechatten Llama 3.1 405B för effektiv och ändamålsenlig kundsupport och hantera en stor mängd frågor samtidigt som de ger korrekta svar.

Pedagogiska verktyg

Lärare och studenter kan använda denna AI för inlärningssyften, inklusive språkträning, informationssökning och interaktiva handledningssessioner.

Skapande av innehåll

Skribenter och marknadsförare kan använda AI för att generera idéer, utarbeta innehåll och till och med redigera och förbättra befintliga texter, vilket effektiviserar processen för att skapa innehåll.

Vem kan använda Online Llama 3.1 405B Chatt

Onlinechatten Llama 3.1 405B är utformad för ett brett spektrum av användare, inklusive:

- Verksamheter: För att förbättra kundinteraktion och supporttjänster.

- Lärare och studenter: Som ett hjälpmedel för inlärning och som en informationsresurs.

- Skapare av innehåll: Att öka produktiviteten och kreativiteten i innehållsgenereringen.

- Forskare: För avancerad textanalys och språkrelaterade studier.

Alternativ till Llama 3.1 405B Modeller och fördelar och nackdelar

| Modell | Proffs | Nackdelar |

|---|---|---|

| GPT-4 | Mycket avancerad, omfattande utbildningsdata | Kräver betydande beräkningsresurser |

| BERT | Utmärkt för att förstå sammanhang i text | Inte lika stark i textgenerering |

| T5 | Mångsidig och kraftfull i både förståelse och generering | Kan vara långsammare på grund av dess komplexitet |

| RoBERTa | Förbättrad robusthet och prestanda jämfört med BERT | Begränsad till specifika uppgifter, mindre mångsidig |

Översikt över specifikationer för modell Llama 3.1

Den Översikt över specifikationer för modell Llama 3.1 ger en detaljerad uppdelning av de viktigaste tekniska specifikationerna för olika Llama 3.1-modeller, inklusive 8B-, 70B- och 405B-versionerna. Denna tabell belyser viktiga aspekter som träningsdata, parameterstorlek, in- och utmatningsmodaliteter, kontextlängd och tokenantal, som alla är avgörande för att förstå prestationsmätningar och AI-kapacitet av dessa modeller. För användare som söker insikter i Lama modeller och deras tillämpningar inom AI-utvecklingfungerar denna översikt som en viktig referens. Oavsett om du utforskar användningsscenarier eller fördjupa sig i de tekniska svårigheterna med online Llama 3.1 405B Chattger denna tabell de grundläggande uppgifter som behövs för att förstå omfattningen och omfattningen av Meta AI:s framsteg inom modellspecifikationer.

| Modell | Utbildningsdata | Parametrar | Inmatningsmodaliteter | Modaliteter för utdata | Sammanhang Längd | GQA | Antal Token | Avstängning för kunskap |

|---|---|---|---|---|---|---|---|---|

| 8B | En ny mix av offentligt tillgänglig online-data. | 8B | Flerspråkig text | Flerspråkig text och kod | 128k | Ja | 15T+ | december 2023 |

| 70B | En ny mix av offentligt tillgänglig online-data. | 70B | Flerspråkig text | Flerspråkig text och kod | 128k | Ja | 15T+ | december 2023 |

| 405B | En ny mix av offentligt tillgänglig online-data. | 405B | Flerspråkig text | Flerspråkig text och kod | 128k | Ja | 15T+ | december 2023 |

Miljöpåverkan och resursanvändning för Llama 3.1 Modeller

Den Miljöpåverkan och resursanvändning för Llama 3.1 Modeller tabellen ger en heltäckande bild av utbildningstid, strömförbrukning, och utsläpp av växthusgaser i samband med olika Llama 3.1-modeller, inklusive versionerna 8B, 70B och 405B. Denna analys är avgörande för att förstå miljöavtrycket från AI-utveckling processer, i synnerhet för modeller med omfattande Tekniska specifikationer och resursbehov. För dem som är intresserade av de bredare konsekvenserna av att använda avancerade AI-kapacitet som online Llama 3.1 405B Chattbelyser denna tabell de olika prestationsmätningar relaterade till hållbarhet. De data som presenteras understryker inte bara de betydande resursbehoven för banbrytande Lama modeller men betonar också vikten av att ta hänsyn till miljöfaktorer i Användarhandböcker och utvecklingsmetoder.

| Modell | Utbildningstid (GPU-timmar) | Utbildning Strömförbrukning (W) | Platsbaserade utsläpp av växthusgaser (ton CO2eq) | Marknadsbaserade utsläpp av växthusgaser (ton CO2eq) |

|---|---|---|---|---|

| Llama 3.1 8B | 1.46M | 700 | 420 | 0 |

| Llama 3.1 70B | 7.0M | 700 | 2,040 | 0 |

| Llama 3.1 405B | 30.84M | 700 | 8,930 | 0 |

| Totalt | 39.3M | 11,390 | 0 |

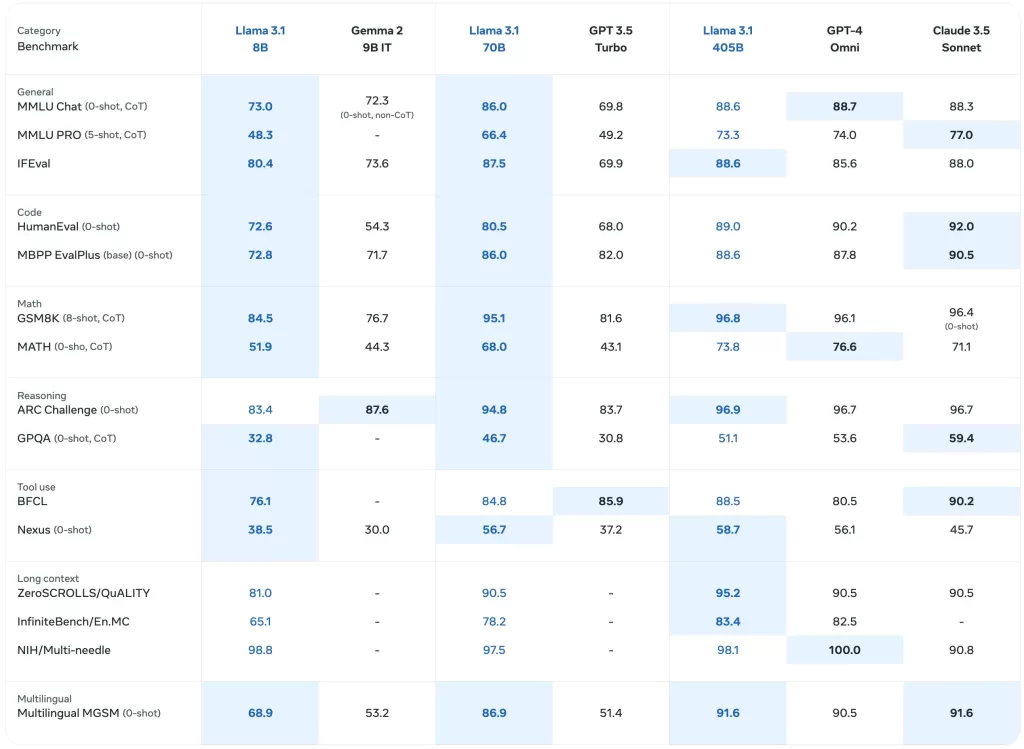

Benchmarkprestanda för Llama 3.1-modeller

Den Benchmarkprestanda för Llama 3.1-modeller tabellen ger en detaljerad utvärdering av olika Llama-modeller, inklusive den senaste Llama 3.1 405Binom en rad olika områden prestationsmätningar. Denna omfattande analys innehåller riktmärken för allmänna uppgifter, kunskapsresonemang, läsförståelse och mer, vilket ger insikter i AI-kapacitet av dessa modeller. För dem som är intresserade av AI-utveckling och de verkliga tillämpningarna av Lama modellerbelyser denna tabell de Tekniska specifikationer och effektivitet för varje modell. Den fungerar som en värdefull resurs för att förstå den jämförande prestandan hos online Llama 3.1 405B Chatt och dess föregångare i olika användningsscenarier.

Förutbildade modeller för bas

Den Förutbildade modeller för bas tabellen ger en jämförande översikt över Llama 3 och Llama 3.1 modellerna i flera olika riktmärken och mätvärden. Det här avsnittet innehåller data om allmän prestanda, kunskapsresonemang och läsförståelse, vilket återspeglar modellernas Tekniska specifikationer och AI-kapacitet. Med detaljerade resultat för varje modell, inklusive Llama 3.1 405Bär denna tabell viktig för att bedöma dessa modellers initiala prestanda i olika sammanhang. För användare som utforskar online Llama 3.1 405B Chatt och dess effektivitet, ger denna tabell värdefulla insikter i de grundläggande riktmärken som ligger till grund för dessa Lama modeller.

| Kategori | Riktmärke | # bilder | Metrisk | Llama 3 8B | Llama 3.1 8B | Llama 3 70B | Llama 3.1 70B | Llama 3.1 405B |

|---|---|---|---|---|---|---|---|---|

| Allmänt | MMLU | 5 | makro_avg/acc_char | 66.7 | 66.7 | 79.5 | 79.3 | 85.2 |

| MMLU-Pro (CoT) | 5 | makro_avg/acc_char | 36.2 | 37.1 | 55.0 | 53.8 | 61.6 | |

| AGIEval Engelska | 3-5 | genomsnitt/acc_char | 47.1 | 47.8 | 63.0 | 64.6 | 71.6 | |

| CommonSenseQA | 7 | acc_char | 72.6 | 75.0 | 83.8 | 84.1 | 85.8 | |

| Winogrande | 5 | acc_char | – | 60.5 | – | 83.3 | 86.7 | |

| BIG-Bench hård (CoT) | 3 | genomsnitt/em | 61.1 | 64.2 | 81.3 | 81.6 | 85.9 | |

| ARC-utmaning | 25 | acc_char | 79.4 | 79.7 | 93.1 | 92.9 | 96.1 | |

| Kunskap Resonemang | TriviaQA-Wiki | 5 | em | 78.5 | 77.6 | 89.7 | 89.8 | 91.8 |

| Läsförståelse | SQuAD | 1 | em | 76.4 | 77.0 | 85.6 | 81.8 | 89.3 |

| QuAC (F1) | 1 | f1 | 44.4 | 44.9 | 51.1 | 51.1 | 53.6 | |

| BoolQ | 0 | acc_char | 75.7 | 75.0 | 79.0 | 79.4 | 80.0 | |

| DROP (F1) | 3 | f1 | 58.4 | 59.5 | 79.7 | 79.6 | 84.8 |

Instruktion Tunade modeller

Den Instruktion Tunade modeller tabellen ger en fokuserad titt på hur Llama 3.1 modeller, i synnerhet de Llama 3.1 405B, prestera när de finjusteras för specifika uppgifter. Det här avsnittet innehåller prestandamätningar för uppgifter som följer instruktioner, kodutvärdering och resonemang, och belyser de förbättrade AI-kapacitet uppnås genom justering av instruktionerna. Det är en viktig resurs för att förstå modellspecifikationer som driver den online Llama 3.1 405B Chatts förmåga att hantera komplexa frågor och uppgifter. Denna tabell är ovärderlig för dem som utvecklar applikationer eller skapar Användarhandböcker som utnyttjar den Llama 3.1 modellernas avancerade kapacitet.

| Kategori | Riktmärke | # bilder | Metrisk | Llama 3 8B Instruktion | Llama 3.1 8B Instruktion | Llama 3 70B Instruktion | Llama 3.1 70B Instruktion | Llama 3.1 405B Instruktion |

|---|---|---|---|---|---|---|---|---|

| Allmänt | MMLU | 5 | makro_avg/acc | 68.5 | 69.4 | 82.0 | 83.6 | 87.3 |

| MMLU (CoT) | 0 | makro_avg/acc | 65.3 | 73.0 | 80.9 | 86.0 | 88.6 | |

| MMLU-Pro (CoT) | 5 | mikro_avg/acc_char | 45.5 | 48.3 | 63.4 | 66.4 | 73.3 | |

| IFEval | – | – | 76.8 | 80.4 | 82.9 | 87.5 | 88.6 | |

| Resonemang | ARC-C | 0 | acc | 82.4 | 83.4 | 94.4 | 94.8 | 96.9 |

| GPQA | 0 | em | 34.6 | 30.4 | 39.5 | 41.7 | 50.7 | |

| Kod | HumanEval | 0 | pass@1 | 60.4 | 72.6 | 81.7 | 80.5 | 89.0 |

| MBPP ++ basversion | 0 | pass@1 | 70.6 | 72.8 | 82.5 | 86.0 | 88.6 | |

| Multipl-E HumanEval | 0 | pass@1 | – | 50.8 | – | 65.5 | 75.2 | |

| Multipl-E MBPP | 0 | pass@1 | – | 52.4 | – | 62.0 | 65.7 | |

| Matematik | GSM-8K (CoT) | 8 | em_maj1@1 | 80.6 | 84.5 | 93.0 | 95.1 | 96.8 |

| MATH (CoT) | 0 | final_em | 29.1 | 51.9 | 51.0 | 68.0 | 73.8 | |

| Användning av verktyg | API-bank | 0 | acc | 48.3 | 82.6 | 85.1 | 90.0 | 92.0 |

| BFCL | 0 | acc | 60.3 | 76.1 | 83.0 | 84.8 | 88.5 | |

| Gorilla Benchmark API Bench | 0 | acc | 1.7 | 8.2 | 14.7 | 29.7 | 35.3 | |

| Nexus (0-skott) | 0 | makro_avg/acc | 18.1 | 38.5 | 47.8 | 56.7 | 58.7 | |

| Flerspråkig | Flerspråkig MGSM (CoT) | 0 | em | – | 68.9 | – | 86.9 | 91.6 |

Flerspråkiga riktmärken

Den Flerspråkiga riktmärken tabellen visar prestandan för Llama 3.1 modellerna på olika språk, bland annat portugisiska, spanska, italienska, tyska, franska, hindi och thailändska. Detta avsnitt illustrerar modellernas förmåga att hantera flerspråkig indata och ger prestandamått som är specifika för varje språk. För dem som är intresserade av att distribuera online Llama 3.1 405B Chatt i olika språkliga sammanhang, belyser denna tabell de AI-kapacitet och Tekniska specifikationer som gör dessa modeller mångsidiga på olika språk. Det är en viktig resurs för att förstå hur väl Lama modeller uppträda globalt användningsscenarier och för att utforma effektiva Användarhandböcker.

| Kategori | Riktmärke | Språk | Llama 3.1 8B | Llama 3.1 70B | Llama 3.1 405B |

|---|---|---|---|---|---|

| Allmänt | MMLU (5-skott, makro_avg/acc) | Portugisiska | 62.12 | 80.13 | 84.95 |

| Spanska | 62.45 | 80.05 | 85.08 | ||

| Italienska | 61.63 | 80.4 | 85.04 | ||

| Tysk | 60.59 | 79.27 | 84.36 | ||

| Franska | 62.34 | 79.82 | 84.66 | ||

| Hindi | 50.88 | 74.52 | 80.31 | ||

| Thai | 50.32 | 72.95 | 78.21 |

Modellutvärderingar med Benchmarks