Llama 3.1 405B Chat com pesquisa na Web

Tentar Reflection 70B Chat - Baseado no Llama 3.1

Apoio linguístico

Inglês: A minha língua materna!

espanholTambém estou a conversar em espanhol!

francês: Oui, je parle Français, matey!

alemão: Aye, ich spreche Deutsch, too!

italiano: Ciao! Estou a falar em italiano, amigo!

Português: Olá! Eu também estou a falar português!

holandês: Olá! Estou a falar em neerlandês, amigo!

Russo: Привет! Eu também estou a falar Русский!

Chinês(Simplificado) e (Tradicional) - Sim, eu também falo mandarim!

Japonês: Konnichiwa! Eu também estou a conversar!

coreano: - Sim, eu também estou a falar Hangul!

Árabe: مرحبا! Eu estou conversando em العربية, também!

hebraicoשלום! Eu estou a falar עברית, também!

* Dependendo da velocidade da sua Internet, o carregamento do modelo em linha pode demorar alguns segundos.

Online Llama 3.1 Chat | Modo de Instrução

Perguntas frequentes sobre o Llama 3.1

1. O que é o Meta Llama 3.1 405B?

O Meta Llama 3.1 é o mais recente modelo linguístico da Meta, com 405 mil milhões de parâmetros. Oferece capacidades avançadas no processamento de linguagem natural, incluindo geração de texto, tradução de linguagem e sistemas de conversação.

A maneira mais fácil de usar o Llama 3.1 é Llama AI Online

2. Como posso aceder ao Meta Llama 3.1?

Pode aceder ao Meta Llama 3.1 e aos seus recursos através do sítio Web oficial llama.meta.com e explore a ficha de modelo completa e as instruções de utilização em Repositório GitHub do Meta.

3. O que é que torna o Meta Llama 3.1 diferente das versões anteriores?

O Meta Llama 3.1 possui 405 mil milhões de parâmetros, o que o torna um dos modelos de linguagem mais poderosos disponíveis. Oferece maior precisão e eficiência na compreensão e geração de linguagem natural.

4. Quais são as principais aplicações do Meta Llama 3.1 405B?

O Meta Llama 3.1 foi concebido para várias aplicações, incluindo geração de texto, tradução de línguas e sistemas de conversação, o que o torna uma ferramenta versátil para programadores e investigadores.

5. Como é que o Meta Llama 3.1 melhora as tarefas de processamento de linguagem natural?

Com os seus parâmetros extensivos e arquitetura avançada, o Meta Llama 3.1 fornece resultados mais precisos e contextualmente relevantes, melhorando o desempenho das tarefas de processamento de linguagem natural.

6. Onde posso encontrar o modelo de cartão para o Meta Llama 3.1?

O cartão de modelo para o Meta Llama 3.1 pode ser encontrado no repositório oficial do Meta no GitHub. Inclui informações detalhadas sobre as capacidades do modelo, directrizes de utilização e especificações técnicas.

7. O Meta Llama 3.1 está disponível para utilização em código aberto?

Sim, o Meta Llama 3.1 está disponível para utilização em código aberto. A Meta fornece recursos e documentação abrangentes para ajudar os programadores a integrar e utilizar o modelo de forma eficaz.

8. Como posso utilizar o Meta Llama 3.1 para aplicações de conversação em linha?

O Meta Llama 3.1 pode ser integrado em aplicações de conversação em linha para melhorar as capacidades de conversação. Pode tirar partido da sua compreensão avançada da linguagem natural para criar chatbots mais interactivos e receptivos.

9. Que recursos estão disponíveis para aprender a utilizar o Meta Llama 3.1?

A Meta oferece recursos extensivos, incluindo um cartão de modelo detalhado, instruções de utilização e exemplos no seu Repositório GitHub. Além disso, a melhor ferramenta para explorar o Meta Llama 3.1 é através de https://llamaai.online/.

10. O Meta Llama 3.1 pode ser utilizado para tarefas de tradução de línguas?

Sim, o Meta Llama 3.1 é altamente eficaz para tarefas de tradução de línguas. As suas capacidades avançadas de processamento de linguagem natural garantem traduções precisas e contextualmente adequadas em diferentes línguas.

Chat Online Llama 3.1 405B: Um guia detalhado

O Meta Llama 3.1 é o mais recente modelo linguístico da Meta, com 405 mil milhões de parâmetros. Oferece capacidades avançadas no processamento de linguagem natural, incluindo geração de texto, tradução de linguagem e sistemas de conversação.

Índice

- O que é o Llama 3.1 405B?

- Importância do Llama 3.1 405B para a Meta AI

- Vantagens da utilização do Online Llama 3.1 405B Chat

- Cenários adequados para a utilização do Chat Online Llama 3.1 405B

- Quem pode utilizar o Online Llama 3.1 405B Chat

- Alternativas aos modelos Llama 3.1 405B e prós e contras

O que é o Llama 3.1 405B?

O Llama 3.1 405B é a mais recente iteração da série Llama da Meta AI, apresentando avanços significativos no processamento e compreensão da linguagem natural. Este modelo possui 405 mil milhões de parâmetros, o que o torna um dos modelos de IA mais poderosos até à data. As suas principais aplicações incluem a tradução de línguas, a IA de conversação e a análise avançada de texto.

Importância do Llama 3.1 405B para a Meta AI

O modelo Llama 3.1 405B é uma pedra angular da estratégia da Meta AI para alargar os limites das capacidades de IA. O seu vasto conjunto de parâmetros permite um processamento de linguagem mais matizado e preciso, o que é crucial para o desenvolvimento de aplicações de IA da próxima geração. Este modelo suporta uma vasta gama de tarefas, desde simples chatbots a complexas ferramentas de análise de dados, sublinhando o compromisso da Meta AI para com a inovação.

Vantagens da utilização do Online Llama 3.1 405B Chat

Desempenho melhorado

O chat online Llama 3.1 405B oferece um desempenho inigualável em termos de precisão e velocidade de resposta. Os utilizadores beneficiam de um parceiro de conversação altamente reativo e inteligente, capaz de compreender e gerar texto semelhante ao humano.

Acessibilidade

Ao fornecer uma interface online, o Meta AI garante que os utilizadores podem aceder às poderosas funcionalidades do Llama 3.1 405B sem necessidade de hardware ou conhecimentos técnicos extensivos. Isto democratiza o acesso a capacidades avançadas de IA.

Versatilidade

A plataforma de conversação em linha pode ser utilizada em vários sectores, incluindo o serviço ao cliente, a educação e a criação de conteúdos. A sua capacidade de compreender e gerar respostas contextualmente relevantes torna-a uma ferramenta valiosa tanto para profissionais como para entusiastas.

Cenários adequados para a utilização do Chat Online Llama 3.1 405B

Apoio ao cliente

As empresas podem tirar partido do chat online Llama 3.1 405B para um apoio ao cliente eficiente e eficaz, tratando um grande volume de questões em simultâneo e dando respostas precisas.

Ferramentas educativas

Os educadores e os estudantes podem utilizar esta IA para fins de aprendizagem, incluindo a prática de línguas, a recuperação de informações e sessões de tutoria interactivas.

Criação de conteúdos

Os redactores e os profissionais de marketing podem utilizar a IA para gerar ideias, redigir conteúdos e até editar e melhorar textos existentes, simplificando o processo de criação de conteúdos.

Quem pode utilizar o Online Llama 3.1 405B Chat

O chat online Llama 3.1 405B foi concebido para uma vasta gama de utilizadores, incluindo:

- Empresas: Para melhorar a interação com o cliente e os serviços de apoio.

- Educadores e estudantes: Como auxiliar de aprendizagem e recurso de informação.

- Criadores de conteúdos: Aumentar a produtividade e a criatividade na produção de conteúdos.

- Investigadores: Para efetuar análises de texto avançadas e estudos relacionados com a língua.

Alternativas aos modelos Llama 3.1 405B e prós e contras

| Modelo | Prós | Contras |

|---|---|---|

| GPT-4 | Dados de formação muito avançados e extensos | Requer recursos computacionais significativos |

| BERT | Excelente para compreender o contexto do texto | Não tão forte na geração de texto |

| T5 | Versátil e poderoso tanto na compreensão como na geração | Pode ser mais lento devido à sua complexidade |

| RoBERTa | Robustez e desempenho melhorados em relação ao BERT | Limitado a tarefas específicas, menos versátil |

Especificações do modelo Llama 3.1 Descrição geral

O Especificações do modelo Llama 3.1 Descrição geral fornece uma análise detalhada das principais especificações técnicas de vários modelos Llama 3.1, incluindo as versões 8B, 70B e 405B. Esta tabela destaca aspectos cruciais como os dados de treino, o tamanho dos parâmetros, as modalidades de entrada e de saída, o comprimento do contexto e a contagem de tokens, todos eles essenciais para compreender a indicadores de desempenho e Capacidades de IA destes modelos. Para os utilizadores que procuram informações sobre Modelos de lamas e suas aplicações em Desenvolvimento da IAesta visão geral serve como uma referência essencial. Quer esteja a explorar cenários de utilização ou aprofundar os pormenores técnicos de online Llama 3.1 405B ChatEste quadro fornece os dados fundamentais necessários para compreender a escala e o âmbito dos avanços da Meta IA em especificações do modelo.

| Modelo | Dados de treino | Parâmetros | Modalidades de entrada | Modalidades de saída | Contexto Comprimento | GQA | Contagem de fichas | Limite de conhecimentos |

|---|---|---|---|---|---|---|---|---|

| 8B | Uma nova combinação de dados em linha publicamente disponíveis. | 8B | Texto multilingue | Texto e código multilingues | 128k | Sim | 15T+ | dezembro de 2023 |

| 70B | Uma nova combinação de dados em linha publicamente disponíveis. | 70B | Texto multilingue | Texto e código multilingues | 128k | Sim | 15T+ | dezembro de 2023 |

| 405B | Uma nova combinação de dados em linha publicamente disponíveis. | 405B | Texto multilingue | Texto e código multilingues | 128k | Sim | 15T+ | dezembro de 2023 |

Impacto ambiental e utilização de recursos da lama 3.1 Modelos

O Impacto ambiental e utilização de recursos da lama 3.1 Modelos O quadro oferece uma visão global da tempo de formação, consumo de energiae emissões de gases com efeito de estufa associados aos diferentes modelos de Llama 3.1, incluindo as versões 8B, 70B e 405B. Esta análise é crucial para compreender a pegada ambiental da Desenvolvimento da IA processos, nomeadamente para modelos com especificações técnicas e requisitos de recursos. Para os interessados nas implicações mais amplas da implantação de sistemas avançados de Capacidades de IA como o online Llama 3.1 405B Chateste quadro esclarece a indicadores de desempenho relacionados com a sustentabilidade. Os dados apresentados não só sublinham as necessidades substanciais de recursos das Modelos de lamas mas também destaca a importância de considerar os factores ambientais na guias do utilizador e práticas de desenvolvimento.

| Modelo | Tempo de formação (horas GPU) | Formação Consumo de energia (W) | Emissões de gases com efeito de estufa com base na localização (toneladas de CO2eq) | Emissões de gases com efeito de estufa baseadas no mercado (toneladas de CO2eq) |

|---|---|---|---|---|

| Lhama 3.1 8B | 1.46M | 700 | 420 | 0 |

| Lhama 3.1 70B | 7.0M | 700 | 2,040 | 0 |

| Lhama 3.1 405B | 30.84M | 700 | 8,930 | 0 |

| Total | 39.3M | 11,390 | 0 |

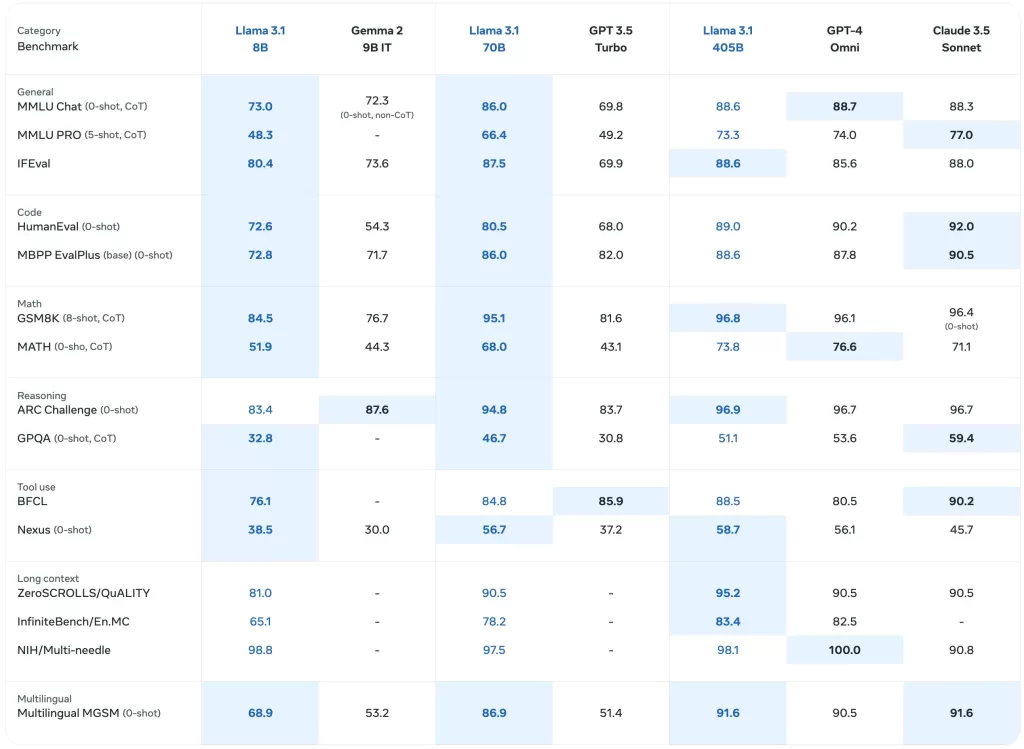

Desempenho de referência dos modelos Llama 3.1

O Desempenho de referência dos modelos Llama 3.1 O quadro apresenta uma avaliação pormenorizada de vários modelos Llama, incluindo o mais recente Lhama 3.1 405B, numa gama de indicadores de desempenho. Esta análise exaustiva inclui indicadores de referência para tarefas gerais, raciocínio de conhecimento, compreensão de leitura e muito mais, oferecendo uma visão sobre os Capacidades de IA destes modelos. Para os interessados em Desenvolvimento da IA e as aplicações no mundo real de Modelos de lamaseste quadro destaca os especificações técnicas e a eficácia de cada modelo. Constitui um recurso valioso para compreender o desempenho comparativo dos online Llama 3.1 405B Chat e os seus antecessores em vários cenários de utilização.

Modelos pré-treinados de base

O Modelos pré-treinados de base O quadro apresenta uma panorâmica comparativa dos Lhama 3 e Lhama 3.1 modelos em vários parâmetros de referência e métricas. Esta secção inclui dados sobre o desempenho geral, o raciocínio do conhecimento e a compreensão da leitura, reflectindo a especificações técnicas e Capacidades de IA. Com resultados pormenorizados para cada modelo, incluindo o Lhama 3.1 405BPara os utilizadores que exploram os modelos de cálculo, este quadro é essencial para avaliar o desempenho inicial destes modelos numa variedade de contextos. Para os utilizadores que exploram online Llama 3.1 405B Chat e a sua eficácia, este quadro oferece informações valiosas sobre os parâmetros de referência fundamentais que sustentam estas Modelos de lamas.

| Categoria | Referência | # Tiros | Métrica | Lhama 3 8B | Lhama 3.1 8B | Lhama 3 70B | Lhama 3.1 70B | Lhama 3.1 405B |

|---|---|---|---|---|---|---|---|---|

| Geral | MMLU | 5 | macro_avg/acc_char | 66.7 | 66.7 | 79.5 | 79.3 | 85.2 |

| MMLU-Pro (CoT) | 5 | macro_avg/acc_char | 36.2 | 37.1 | 55.0 | 53.8 | 61.6 | |

| AGIEval Inglês | 3-5 | média/acc_char | 47.1 | 47.8 | 63.0 | 64.6 | 71.6 | |

| CommonSenseQA | 7 | acc_char | 72.6 | 75.0 | 83.8 | 84.1 | 85.8 | |

| Winogrande | 5 | acc_char | – | 60.5 | – | 83.3 | 86.7 | |

| BIG-Bench Hard (CoT) | 3 | média/em | 61.1 | 64.2 | 81.3 | 81.6 | 85.9 | |

| Desafio ARC | 25 | acc_char | 79.4 | 79.7 | 93.1 | 92.9 | 96.1 | |

| Raciocínio de conhecimento | TriviaQA-Wiki | 5 | em | 78.5 | 77.6 | 89.7 | 89.8 | 91.8 |

| Compreensão da leitura | SQuAD | 1 | em | 76.4 | 77.0 | 85.6 | 81.8 | 89.3 |

| QuAC (F1) | 1 | f1 | 44.4 | 44.9 | 51.1 | 51.1 | 53.6 | |

| BoolQ | 0 | acc_char | 75.7 | 75.0 | 79.0 | 79.4 | 80.0 | |

| DROP (F1) | 3 | f1 | 58.4 | 59.5 | 79.7 | 79.6 | 84.8 |

Modelos afinados por instrução

O Modelos afinados por instrução O quadro apresenta uma visão específica da forma como Lhama 3.1 modelos, nomeadamente o Lhama 3.1 405BO desempenho do sistema é melhorado quando afinado para tarefas específicas. Esta secção inclui métricas de desempenho para tarefas de seguimento de instruções, avaliação de código e raciocínio, destacando a melhoria do Capacidades de IA alcançada através da afinação das instruções. É um recurso fundamental para compreender a especificações do modelo que impulsionam o online Llama 3.1 405B Chatpara lidar com consultas e tarefas complexas. Esta tabela é inestimável para quem está a desenvolver aplicações ou a criar guias do utilizador que potenciam o Lhama 3.1 capacidades avançadas dos modelos.

| Categoria | Referência | # Tiros | Métrica | Llama 3 8B Instrução | Llama 3.1 8B Instrução | Llama 3 70B Instrução | Llama 3.1 70B Instrução | Llama 3.1 405B Instrução |

|---|---|---|---|---|---|---|---|---|

| Geral | MMLU | 5 | macro_avg/acc | 68.5 | 69.4 | 82.0 | 83.6 | 87.3 |

| MMLU (CoT) | 0 | macro_avg/acc | 65.3 | 73.0 | 80.9 | 86.0 | 88.6 | |

| MMLU-Pro (CoT) | 5 | micro_avg/acc_char | 45.5 | 48.3 | 63.4 | 66.4 | 73.3 | |

| IFEval | – | – | 76.8 | 80.4 | 82.9 | 87.5 | 88.6 | |

| Raciocínio | ARC-C | 0 | acc | 82.4 | 83.4 | 94.4 | 94.8 | 96.9 |

| GPQA | 0 | em | 34.6 | 30.4 | 39.5 | 41.7 | 50.7 | |

| Código | HumanEval | 0 | pass@1 | 60.4 | 72.6 | 81.7 | 80.5 | 89.0 |

| MBPP ++ versão de base | 0 | pass@1 | 70.6 | 72.8 | 82.5 | 86.0 | 88.6 | |

| Multipl-E HumanEval | 0 | pass@1 | – | 50.8 | – | 65.5 | 75.2 | |

| Multipl-E MBPP | 0 | pass@1 | – | 52.4 | – | 62.0 | 65.7 | |

| Matemática | GSM-8K (CoT) | 8 | em_maj1@1 | 80.6 | 84.5 | 93.0 | 95.1 | 96.8 |

| MATEMÁTICA (CoT) | 0 | final_em | 29.1 | 51.9 | 51.0 | 68.0 | 73.8 | |

| Utilização de ferramentas | API-Banco | 0 | acc | 48.3 | 82.6 | 85.1 | 90.0 | 92.0 |

| BFCL | 0 | acc | 60.3 | 76.1 | 83.0 | 84.8 | 88.5 | |

| Banco de dados API do Gorilla Benchmark | 0 | acc | 1.7 | 8.2 | 14.7 | 29.7 | 35.3 | |

| Nexus (0 tiros) | 0 | macro_avg/acc | 18.1 | 38.5 | 47.8 | 56.7 | 58.7 | |

| Multilingue | MGSM multilingue (CoT) | 0 | em | – | 68.9 | – | 86.9 | 91.6 |

Referências multilingues

O Referências multilingues O quadro apresenta o desempenho de Lhama 3.1 modelos em várias línguas, incluindo português, espanhol, italiano, alemão, francês, hindi e tailandês. Esta secção ilustra a capacidade dos modelos para lidar com entradas multilingues e fornece métricas de desempenho específicas para cada língua. Para os interessados em implementar o online Llama 3.1 405B Chat em diversos contextos linguísticos, este quadro destaca as Capacidades de IA e especificações técnicas que tornam estes modelos versáteis em diferentes línguas. É um recurso fundamental para compreender até que ponto o Modelos de lamas atuar a nível mundial cenários de utilização e para a elaboração de guias do utilizador.

| Categoria | Referência | Língua | Lhama 3.1 8B | Lhama 3.1 70B | Lhama 3.1 405B |

|---|---|---|---|---|---|

| Geral | MMLU (5 disparos, macro_avg/acc) | Português | 62.12 | 80.13 | 84.95 |

| espanhol | 62.45 | 80.05 | 85.08 | ||

| italiano | 61.63 | 80.4 | 85.04 | ||

| alemão | 60.59 | 79.27 | 84.36 | ||

| francês | 62.34 | 79.82 | 84.66 | ||

| Hindi | 50.88 | 74.52 | 80.31 | ||

| Tailandês | 50.32 | 72.95 | 78.21 |

Avaliações de modelos com valores de referência