Llama 3.1 405B Czat z wyszukiwarką internetową

Spróbuj Reflection 70B Chat - oparty na Llama 3.1

Wsparcie językowe

Angielski: Mój ojczysty język!

HiszpańskiJa też rozmawiam po hiszpańsku!

Francuski: Oui, je parle Français, matey!

Niemiecki: Aye, ich spreche Deutsch, too!

Włoski: Ciao! Rozmawiam po włosku, stary!

Portugalski: Olá! Ja też mówię po portugalsku!

Holenderski: Hallo! Rozmawiam po holendersku, stary!

Rosyjski: Привет! Ja też mówię po Русский!

Chiński(Uproszczony) i (Tradycyjny) - Tak, ja też mówię po mandaryńsku!

Japoński: Konnichiwa! Ja też będę rozmawiał!

KoreańskiTak, ja też mówię w Hangul!

Arabski: مرحبا! Ja też rozmawiam w العربية!

Hebrajskiשלום! Ja też mówię עברית!

* W zależności od szybkości połączenia internetowego, załadowanie modelu online może potrwać kilka sekund.

Online Llama 3.1 Czat | Tryb instruktażowy

Najczęściej zadawane pytania dotyczące Llama 3.1

1. Czym jest Meta Llama 3.1 405B?

Meta Llama 3.1 to najnowszy model językowy firmy Meta, oferujący 405 miliardów parametrów. Oferuje zaawansowane możliwości przetwarzania języka naturalnego, w tym generowanie tekstu, tłumaczenie językowe i systemy konwersacji.

Najprostszym sposobem użycia Llama 3.1 jest Llama AI Online

2. Jak mogę uzyskać dostęp do Meta Llama 3.1?

Dostęp do Meta Llama 3.1 i jego zasobów można uzyskać za pośrednictwem oficjalnej strony internetowej llama.meta.com i zapoznaj się z obszerną kartą modelu oraz instrukcjami użytkowania na stronie Repozytorium Meta w serwisie GitHub.

3. Czym Meta Llama 3.1 różni się od poprzednich wersji?

Meta Llama 3.1 posiada 405 miliardów parametrów, co czyni go jednym z najpotężniejszych dostępnych modeli językowych. Oferuje zwiększoną dokładność i wydajność w rozumieniu i generowaniu języka naturalnego.

4. Jakie są główne zastosowania Meta Llama 3.1 405B?

Meta Llama 3.1 jest przeznaczona do różnych zastosowań, w tym do generowania tekstu, tłumaczenia języka i systemów konwersacyjnych, co czyni ją wszechstronnym narzędziem dla programistów i badaczy.

5. W jaki sposób Meta Llama 3.1 usprawnia zadania przetwarzania języka naturalnego?

Dzięki rozbudowanym parametrom i zaawansowanej architekturze, Meta Llama 3.1 zapewnia bardziej dokładne i kontekstowo istotne wyniki, zwiększając wydajność zadań przetwarzania języka naturalnego.

6. Gdzie mogę znaleźć kartę modelu dla Meta Llama 3.1?

Kartę modelu dla Meta Llama 3.1 można znaleźć w oficjalnym repozytorium Meta GitHub. Zawiera ona szczegółowe informacje o możliwościach modelu, wskazówki dotyczące użytkowania i specyfikacje techniczne.

7. Czy Meta Llama 3.1 jest dostępna do użytku open-source?

Tak, Meta Llama 3.1 jest dostępna do użytku open-source. Meta zapewnia kompleksowe zasoby i dokumentację, aby pomóc programistom w integracji i efektywnym wykorzystaniu modelu.

8. Jak mogę używać Meta Llama 3.1 w aplikacjach do czatu online?

Meta Llama 3.1 może być zintegrowana z aplikacjami czatu online w celu zwiększenia możliwości konwersacyjnych. Zaawansowane rozumienie języka naturalnego pozwala tworzyć bardziej interaktywne i responsywne chatboty.

9. Jakie zasoby są dostępne do nauki korzystania z Meta Llama 3.1?

Meta oferuje obszerne zasoby, w tym szczegółową kartę modelu, instrukcje użytkowania i przykłady na swojej stronie internetowej. Repozytorium GitHub. Ponadto najlepszym narzędziem do eksploracji Meta Llama 3.1 jest https://llamaai.online/.

10. Czy Meta Llama 3.1 może być używana do tłumaczeń językowych?

Tak, Meta Llama 3.1 jest bardzo skuteczna w tłumaczeniach językowych. Jego zaawansowane możliwości przetwarzania języka naturalnego zapewniają dokładne i kontekstowo odpowiednie tłumaczenia w różnych językach.

Online Llama 3.1 405B Chat: Szczegółowy przewodnik

Meta Llama 3.1 to najnowszy model językowy firmy Meta, oferujący 405 miliardów parametrów. Oferuje zaawansowane możliwości przetwarzania języka naturalnego, w tym generowanie tekstu, tłumaczenie językowe i systemy konwersacji.

Spis treści

- Czym jest Llama 3.1 405B?

- Znaczenie Llama 3.1 405B dla Meta AI

- Korzyści z korzystania z czatu online Llama 3.1 405B

- Odpowiednie scenariusze korzystania z czatu online Llama 3.1 405B

- Kto może korzystać z czatu Online Llama 3.1 405B?

- Alternatywy dla modeli Llama 3.1 405B oraz wady i zalety

Czym jest Llama 3.1 405B?

Llama 3.1 405B to najnowsza iteracja serii Llama firmy Meta AI, oferująca znaczące postępy w przetwarzaniu i rozumieniu języka naturalnego. Model ten posiada 405 miliardów parametrów, co czyni go jednym z najpotężniejszych modeli sztucznej inteligencji do tej pory. Jego główne zastosowania obejmują tłumaczenia językowe, konwersacyjną sztuczną inteligencję i zaawansowaną analizę tekstu.

Znaczenie Llama 3.1 405B dla Meta AI

Model Llama 3.1 405B jest kamieniem węgielnym strategii Meta AI polegającej na przesuwaniu granic możliwości sztucznej inteligencji. Jego szeroki zestaw parametrów pozwala na bardziej zniuansowane i dokładne przetwarzanie języka, co ma kluczowe znaczenie dla rozwoju aplikacji AI nowej generacji. Model ten obsługuje szeroki zakres zadań, od prostych chatbotów po złożone narzędzia do analizy danych, podkreślając zaangażowanie Meta AI w innowacje.

Korzyści z korzystania z czatu online Llama 3.1 405B

Zwiększona wydajność

Czat online Llama 3.1 405B oferuje niezrównaną wydajność pod względem dokładności i szybkości odpowiedzi. Użytkownicy korzystają z wysoce responsywnego i inteligentnego partnera konwersacyjnego, zdolnego do rozumienia i generowania tekstu podobnego do ludzkiego.

Dostępność

Zapewniając interfejs online, Meta AI zapewnia użytkownikom dostęp do zaawansowanych funkcji Llama 3.1 405B bez potrzeby posiadania rozległej wiedzy sprzętowej lub technicznej. Demokratyzuje to dostęp do zaawansowanych możliwości sztucznej inteligencji.

Wszechstronność

Platforma czatu online może być wykorzystywana w różnych branżach, w tym w obsłudze klienta, edukacji i tworzeniu treści. Jej zdolność do rozumienia i generowania kontekstowo odpowiednich odpowiedzi sprawia, że jest to cenne narzędzie zarówno dla profesjonalistów, jak i entuzjastów.

Odpowiednie scenariusze korzystania z czatu online Llama 3.1 405B

Obsługa klienta

Firmy mogą wykorzystać czat online Llama 3.1 405B do wydajnej i skutecznej obsługi klienta, obsługując jednocześnie dużą liczbę zapytań i udzielając dokładnych odpowiedzi.

Narzędzia edukacyjne

Nauczyciele i studenci mogą wykorzystywać tę sztuczną inteligencję do celów edukacyjnych, w tym do ćwiczeń językowych, wyszukiwania informacji i interaktywnych sesji korepetycji.

Tworzenie treści

Pisarze i marketerzy mogą wykorzystywać sztuczną inteligencję do generowania pomysłów, tworzenia treści, a nawet edytowania i ulepszania istniejących tekstów, usprawniając proces tworzenia treści.

Kto może korzystać z czatu Online Llama 3.1 405B?

Czat online Llama 3.1 405B jest przeznaczony dla szerokiego grona użytkowników, w tym:

- Firmy: W celu poprawy interakcji z klientami i usług wsparcia.

- Nauczyciele i uczniowie: Jako pomoc w nauce i źródło informacji.

- Twórcy treści: Zwiększenie produktywności i kreatywności w generowaniu treści.

- Badacze: Do przeprowadzania zaawansowanej analizy tekstu i badań związanych z językiem.

Alternatywy dla modeli Llama 3.1 405B oraz wady i zalety

| Model | Plusy | Wady |

|---|---|---|

| GPT-4 | Wysoce zaawansowane, obszerne dane treningowe | Wymaga znacznych zasobów obliczeniowych |

| BERT | Doskonały do zrozumienia kontekstu w tekście | Nie tak silny w generowaniu tekstu |

| T5 | Wszechstronny i potężny zarówno w zrozumieniu, jak i generowaniu | Może być wolniejszy ze względu na swoją złożoność |

| RoBERTa | Zwiększona odporność i wydajność w porównaniu do BERT | Ograniczony do określonych zadań, mniej wszechstronny |

Przegląd specyfikacji modelu Llama 3.1

The Przegląd specyfikacji modelu Llama 3.1 zawiera szczegółowe zestawienie kluczowych specyfikacji technicznych dla różnych modeli Llama 3.1, w tym wersji 8B, 70B i 405B. Tabela ta podkreśla kluczowe aspekty, takie jak dane treningowe, rozmiar parametrów, modalności wejściowe i wyjściowe, długość kontekstu i liczba tokenów, z których wszystkie są kluczowe dla zrozumienia modelu Llama 3.1. wskaźniki wydajności oraz Możliwości AI tych modeli. Dla użytkowników szukających wglądu w Modele lamy i ich zastosowania w Rozwój sztucznej inteligencjiNiniejszy przegląd stanowi niezbędne źródło informacji. Niezależnie od tego, czy badasz scenariusze użytkowania lub zagłębiając się w techniczne zawiłości Llama online 3.1 405B CzatTa tabela zawiera podstawowe dane potrzebne do zrozumienia skali i zakresu postępów Meta AI w specyfikacje modelu.

| Model | Dane treningowe | Parametry | Modalności wejściowe | Tryby wyjścia | Długość kontekstu | GQA | Liczba tokenów | Odcięcie wiedzy |

|---|---|---|---|---|---|---|---|---|

| 8B | Nowy zestaw publicznie dostępnych danych online. | 8B | Tekst wielojęzyczny | Wielojęzyczny tekst i kod | 128k | Tak | 15T+ | Grudzień 2023 r. |

| 70B | Nowy zestaw publicznie dostępnych danych online. | 70B | Tekst wielojęzyczny | Wielojęzyczny tekst i kod | 128k | Tak | 15T+ | Grudzień 2023 r. |

| 405B | Nowy zestaw publicznie dostępnych danych online. | 405B | Tekst wielojęzyczny | Wielojęzyczny tekst i kod | 128k | Tak | 15T+ | Grudzień 2023 r. |

Wpływ na środowisko i wykorzystanie zasobów przez lamy 3.1 Modele

The Wpływ na środowisko i wykorzystanie zasobów przez lamy 3.1 Modele tabela oferuje kompleksowe spojrzenie na czas treningu, zużycie energiioraz emisje gazów cieplarnianych związanych z różnymi modelami Llama 3.1, w tym wersjami 8B, 70B i 405B. Analiza ta ma kluczowe znaczenie dla zrozumienia śladu środowiskowego Rozwój sztucznej inteligencji procesy, szczególnie w przypadku modeli z rozległymi specyfikacje techniczne i wymagania dotyczące zasobów. Dla tych, którzy są zainteresowani szerszymi konsekwencjami wdrażania zaawansowanych Możliwości AI jak Llama online 3.1 405B CzatTa tabela rzuca światło na wskaźniki wydajności związanych ze zrównoważonym rozwojem. Przedstawione dane nie tylko podkreślają znaczne zapotrzebowanie na zasoby najnowocześniejszych Modele lamy ale także podkreśla znaczenie uwzględnienia czynników środowiskowych w instrukcje obsługi i praktyki rozwojowe.

| Model | Czas szkolenia (godziny GPU) | Zużycie energii podczas treningu (W) | Emisje gazów cieplarnianych w zależności od lokalizacji (tony ekwiwalentu CO2) | Rynkowe emisje gazów cieplarnianych (tony ekwiwalentu CO2) |

|---|---|---|---|---|

| Llama 3.1 8B | 1.46M | 700 | 420 | 0 |

| Llama 3.1 70B | 7.0M | 700 | 2,040 | 0 |

| Llama 3.1 405B | 30.84M | 700 | 8,930 | 0 |

| Łącznie | 39.3M | 11,390 | 0 |

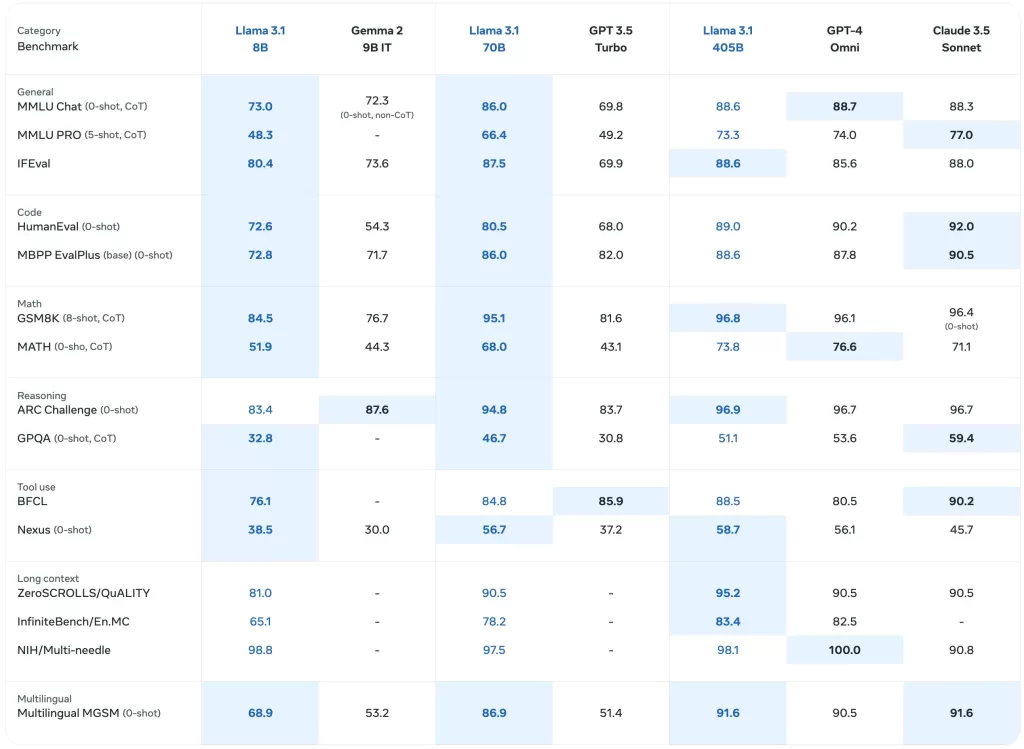

Testy porównawcze wydajności modeli Llama 3.1

The Testy porównawcze wydajności modeli Llama 3.1 Tabela zawiera szczegółową ocenę różnych modeli Llama, w tym najnowszych Llama 3.1 405Bw szerokim zakresie wskaźniki wydajności. Ta kompleksowa analiza obejmuje testy porównawcze dla zadań ogólnych, rozumowania wiedzy, czytania ze zrozumieniem i nie tylko, oferując wgląd w Możliwości AI tych modeli. Dla zainteresowanych Rozwój sztucznej inteligencji i rzeczywiste zastosowania Modele lamyW tej tabeli wyróżniono specyfikacje techniczne i skuteczność każdego modelu. Służy ona jako cenne źródło wiedzy na temat porównawczej wydajności poszczególnych modeli. Llama online 3.1 405B Czat i jego poprzedników w różnych scenariusze użytkowania.

Wstępnie wytrenowane modele bazowe

The Wstępnie wytrenowane modele bazowe Tabela przedstawia przegląd porównawczy Llama 3 oraz Llama 3.1 modeli w kilku testach porównawczych i metrykach. Ta sekcja zawiera dane dotyczące ogólnej wydajności, rozumowania wiedzy i czytania ze zrozumieniem, odzwierciedlające modele specyfikacje techniczne oraz Możliwości AI. Szczegółowe wyniki dla każdego modelu, w tym Llama 3.1 405BTabela ta jest niezbędna do oceny początkowej wydajności tych modeli w różnych kontekstach. Dla użytkowników badających Llama online 3.1 405B Czat i jego skuteczność, niniejsza tabela oferuje cenny wgląd w podstawowe poziomy odniesienia, które stanowią ich podstawę. Modele lamy.

| Kategoria | Benchmark | Strzały # | Metryczny | Llama 3 8B | Llama 3.1 8B | Llama 3 70B | Llama 3.1 70B | Llama 3.1 405B |

|---|---|---|---|---|---|---|---|---|

| Ogólne | MMLU | 5 | macro_avg/acc_char | 66.7 | 66.7 | 79.5 | 79.3 | 85.2 |

| MMLU-Pro (CoT) | 5 | macro_avg/acc_char | 36.2 | 37.1 | 55.0 | 53.8 | 61.6 | |

| AGIEval English | 3-5 | średnia/acc_char | 47.1 | 47.8 | 63.0 | 64.6 | 71.6 | |

| CommonSenseQA | 7 | acc_char | 72.6 | 75.0 | 83.8 | 84.1 | 85.8 | |

| Winogrande | 5 | acc_char | – | 60.5 | – | 83.3 | 86.7 | |

| BIG-Bench Hard (CoT) | 3 | średnia/em | 61.1 | 64.2 | 81.3 | 81.6 | 85.9 | |

| Wyzwanie ARC | 25 | acc_char | 79.4 | 79.7 | 93.1 | 92.9 | 96.1 | |

| Rozumowanie oparte na wiedzy | TriviaQA-Wiki | 5 | em | 78.5 | 77.6 | 89.7 | 89.8 | 91.8 |

| Czytanie ze zrozumieniem | SQuAD | 1 | em | 76.4 | 77.0 | 85.6 | 81.8 | 89.3 |

| QuAC (F1) | 1 | f1 | 44.4 | 44.9 | 51.1 | 51.1 | 53.6 | |

| BoolQ | 0 | acc_char | 75.7 | 75.0 | 79.0 | 79.4 | 80.0 | |

| DROP (F1) | 3 | f1 | 58.4 | 59.5 | 79.7 | 79.6 | 84.8 |

Modele dostrojone do instrukcji

The Modele dostrojone do instrukcji Tabela zapewnia ukierunkowane spojrzenie na to, jak Llama 3.1 modele, w szczególności Llama 3.1 405Bpo dostrojeniu do konkretnych zadań. Ta sekcja zawiera wskaźniki wydajności dla zadań związanych z wykonywaniem instrukcji, oceną kodu i wnioskowaniem, podkreślając ulepszone Możliwości AI osiągnięte poprzez dostrojenie instrukcji. Jest to kluczowe źródło do zrozumienia specyfikacje modelu które napędzają Llama online 3.1 405B Czatdo obsługi złożonych zapytań i zadań. Ta tabela jest nieoceniona dla tych, którzy opracowują aplikacje lub tworzą instrukcje obsługi które wykorzystują Llama 3.1 zaawansowane możliwości modeli.

| Kategoria | Benchmark | Strzały # | Metryczny | Llama 3 8B Instruktaż | Llama 3.1 8B Instruct | Llama 3 70B Instruktaż | Llama 3.1 70B Instruct | Llama 3.1 405B Instruct |

|---|---|---|---|---|---|---|---|---|

| Ogólne | MMLU | 5 | macro_avg/acc | 68.5 | 69.4 | 82.0 | 83.6 | 87.3 |

| MMLU (CoT) | 0 | macro_avg/acc | 65.3 | 73.0 | 80.9 | 86.0 | 88.6 | |

| MMLU-Pro (CoT) | 5 | micro_avg/acc_char | 45.5 | 48.3 | 63.4 | 66.4 | 73.3 | |

| IFEval | – | – | 76.8 | 80.4 | 82.9 | 87.5 | 88.6 | |

| Uzasadnienie | ARC-C | 0 | acc | 82.4 | 83.4 | 94.4 | 94.8 | 96.9 |

| GPQA | 0 | em | 34.6 | 30.4 | 39.5 | 41.7 | 50.7 | |

| Kod | HumanEval | 0 | pass@1 | 60.4 | 72.6 | 81.7 | 80.5 | 89.0 |

| MBPP ++ wersja podstawowa | 0 | pass@1 | 70.6 | 72.8 | 82.5 | 86.0 | 88.6 | |

| Multipl-E HumanEval | 0 | pass@1 | – | 50.8 | – | 65.5 | 75.2 | |

| Multipl-E MBPP | 0 | pass@1 | – | 52.4 | – | 62.0 | 65.7 | |

| Matematyka | GSM-8K (CoT) | 8 | em_maj1@1 | 80.6 | 84.5 | 93.0 | 95.1 | 96.8 |

| MATH (CoT) | 0 | final_em | 29.1 | 51.9 | 51.0 | 68.0 | 73.8 | |

| Korzystanie z narzędzi | API-Bank | 0 | acc | 48.3 | 82.6 | 85.1 | 90.0 | 92.0 |

| BFCL | 0 | acc | 60.3 | 76.1 | 83.0 | 84.8 | 88.5 | |

| Gorilla Benchmark API Bench | 0 | acc | 1.7 | 8.2 | 14.7 | 29.7 | 35.3 | |

| Nexus (strzał 0) | 0 | macro_avg/acc | 18.1 | 38.5 | 47.8 | 56.7 | 58.7 | |

| Wielojęzyczny | Wielojęzyczny MGSM (CoT) | 0 | em | – | 68.9 | – | 86.9 | 91.6 |

Wielojęzyczne testy porównawcze

The Wielojęzyczne testy porównawcze Tabela przedstawia wydajność Llama 3.1 w różnych językach, w tym portugalskim, hiszpańskim, włoskim, niemieckim, francuskim, hindi i tajskim. Ta sekcja ilustruje zdolność modeli do obsługi wielojęzycznych danych wejściowych i zapewnia wskaźniki wydajności specyficzne dla każdego języka. Dla osób zainteresowanych wdrożeniem Llama online 3.1 405B Czat w różnych kontekstach językowych, niniejsza tabela podkreśla Możliwości AI oraz specyfikacje techniczne które sprawiają, że modele te są uniwersalne w różnych językach. Jest to kluczowe źródło informacji pozwalające zrozumieć, jak dobrze Modele lamy działać w skali globalnej scenariusze użytkowania i do tworzenia skutecznych instrukcje obsługi.

| Kategoria | Benchmark | Język | Llama 3.1 8B | Llama 3.1 70B | Llama 3.1 405B |

|---|---|---|---|---|---|

| Ogólne | MMLU (5 zdjęć, macro_avg/acc) | Portugalski | 62.12 | 80.13 | 84.95 |

| Hiszpański | 62.45 | 80.05 | 85.08 | ||

| Włoski | 61.63 | 80.4 | 85.04 | ||

| Niemiecki | 60.59 | 79.27 | 84.36 | ||

| Francuski | 62.34 | 79.82 | 84.66 | ||

| Hindi | 50.88 | 74.52 | 80.31 | ||

| Tajski | 50.32 | 72.95 | 78.21 |

Oceny modeli za pomocą testów porównawczych