Llama 3.1 405B Chat med nettsøk

Prøv Reflection 70B Chat - basert på Llama 3.1

Språkstøtte

Engelsk: Mitt morsmål!

Spansk¡Hola! Jeg snakker også spansk!

Fransk: Oui, je parle français, kompis!

Tysk: Aye, ich spreche Deutsch, også!

Italiensk: Ciao! Jeg snakker italiensk, kompis!

Portugisisk: Olá! Jeg snakker også portugisisk!

Nederlandsk: Hallo! Jeg snakker nederlandsk, kompis!

Russisk: Привет! Jeg snakker også Русский!

Kinesisk: (forenklet) og (tradisjonell) - Ja, jeg snakker også mandarin!

Japansk: Konnichiwa! Jeg er også med!

KoreanskJa, jeg snakker også hangul!

Arabisk: مرحبا! Jeg snakker også العربية!

Hebraisk: שלום! Jeg snakker også עברית!

* Avhengig av internetthastigheten din kan det ta noen sekunder å laste inn modellen på nettet.

Online Llama 3.1 Chat | Instruksjonsmodus

Ofte stilte spørsmål til Llama 3.1

1. Hva er Meta Llama 3.1 405B?

Meta Llama 3.1 er Metas nyeste språkmodell, med 405 milliarder parametere. Den tilbyr avanserte funksjoner innen naturlig språkbehandling, inkludert tekstgenerering, språkoversettelse og samtalesystemer.

Den enkleste måten å bruke Llama 3.1 på er Llama AI Online

2. Hvordan får jeg tilgang til Meta Llama 3.1?

Du kan få tilgang til Meta Llama 3.1 og ressursene via det offisielle nettstedet lama.meta.com og utforske det omfattende modellkortet og bruksanvisningen på Metas GitHub-arkiv.

3. Hva gjør Meta Llama 3.1 forskjellig fra tidligere versjoner?

Meta Llama 3.1 har 405 milliarder parametere, noe som gjør den til en av de kraftigste språkmodellene som finnes. Den gir økt nøyaktighet og effektivitet i forståelsen og genereringen av naturlig språk.

4. Hva er de viktigste bruksområdene til Meta Llama 3.1 405B?

Meta Llama 3.1 er utviklet for ulike bruksområder, blant annet tekstgenerering, språkoversettelse og samtalesystemer, noe som gjør det til et allsidig verktøy for utviklere og forskere.

5. Hvordan forbedrer Meta Llama 3.1 naturlig språkbehandling?

Med sine omfattende parametere og avanserte arkitektur gir Meta Llama 3.1 mer nøyaktige og kontekstuelt relevante resultater, noe som forbedrer ytelsen til naturlige språkbehandlingsoppgaver.

6. Hvor finner jeg modellkortet for Meta Llama 3.1?

Modellkortet for Meta Llama 3.1 finner du på Metas offisielle GitHub-depot. Det inneholder detaljert informasjon om modellens funksjoner, retningslinjer for bruk og tekniske spesifikasjoner.

7. Er Meta Llama 3.1 tilgjengelig for bruk med åpen kildekode?

Ja, Meta Llama 3.1 er tilgjengelig for bruk med åpen kildekode. Meta tilbyr omfattende ressurser og dokumentasjon for å hjelpe utviklere med å integrere og bruke modellen effektivt.

8. Hvordan kan jeg bruke Meta Llama 3.1 til nettbaserte chat-applikasjoner?

Meta Llama 3.1 kan integreres i nettbaserte chatteapplikasjoner for forbedrede samtaleegenskaper. Du kan utnytte den avanserte naturlige språkforståelsen til å skape mer interaktive og responsive chatbots.

9. Hvilke ressurser er tilgjengelige for å lære hvordan du bruker Meta Llama 3.1?

Meta tilbyr omfattende ressurser, inkludert et detaljert modellkort, bruksanvisninger og eksempler på deres GitHub-depot. I tillegg er det beste verktøyet for å utforske Meta Llama 3.1 gjennom https://llamaai.online/.

10. Kan Meta Llama 3.1 brukes til språkoversettelsesoppgaver?

Ja, Meta Llama 3.1 er svært effektivt for språkoversettelsesoppgaver. De avanserte funksjonene for naturlig språkbehandling sikrer nøyaktige og kontekstuelt passende oversettelser på tvers av ulike språk.

Llama 3.1 405B Chat på nett: En grundig veiledning

Meta Llama 3.1 er Metas nyeste språkmodell, med 405 milliarder parametere. Den tilbyr avanserte funksjoner innen naturlig språkbehandling, inkludert tekstgenerering, språkoversettelse og samtalesystemer.

Innholdsfortegnelse

- Hva er Llama 3.1 405B?

- Betydningen av Llama 3.1 405B for Meta AI

- Fordeler med å bruke Online Llama 3.1 405B Chat

- Egnede scenarier for bruk av Online Llama 3.1 405B Chat

- Hvem kan bruke Online Llama 3.1 405B Chat

- Alternativer til Llama 3.1 405B-modeller og fordeler og ulemper

Hva er Llama 3.1 405B?

Llama 3.1 405B er den nyeste utgaven av Meta AIs Llama-serie, og kan skilte med betydelige fremskritt innen naturlig språkbehandling og -forståelse. Denne modellen har 405 milliarder parametere, noe som gjør den til en av de kraftigste AI-modellene til dags dato. De primære bruksområdene inkluderer språkoversettelse, samtale-AI og avansert tekstanalyse.

Betydningen av Llama 3.1 405B for Meta AI

Llama 3.1 405B-modellen er en hjørnestein i Meta AIs strategi for å flytte grensene for AI-kapasiteter. Det store parametersettet gir mulighet for mer nyansert og nøyaktig språkbehandling, noe som er avgjørende for å utvikle neste generasjons AI-applikasjoner. Denne modellen støtter et bredt spekter av oppgaver, fra enkle chatboter til komplekse dataanalyseverktøy, noe som understreker Meta AIs engasjement for innovasjon.

Fordeler med å bruke Online Llama 3.1 405B Chat

Forbedret ytelse

Den nettbaserte Llama 3.1 405B-chatten tilbyr uovertruffen ytelse når det gjelder nøyaktighet og hastighet. Brukerne får en svært responsiv og intelligent samtalepartner som er i stand til å forstå og generere menneskelignende tekst.

Tilgjengelighet

Ved å tilby et nettbasert grensesnitt sørger Meta AI for at brukerne får tilgang til de kraftige funksjonene i Llama 3.1 405B uten behov for omfattende maskinvare eller teknisk ekspertise. Dette demokratiserer tilgangen til avanserte AI-funksjoner.

Allsidighet

Chat-plattformen kan brukes i ulike bransjer, blant annet kundeservice, utdanning og innholdsproduksjon. Dens evne til å forstå og generere kontekstuelt relevante svar gjør den til et verdifullt verktøy for både profesjonelle og entusiaster.

Egnede scenarier for bruk av Online Llama 3.1 405B Chat

Kundestøtte

Bedrifter kan utnytte den nettbaserte Llama 3.1 405B-chatten til effektiv kundestøtte og håndtere et stort antall spørsmål samtidig, samtidig som de gir nøyaktige svar.

Pedagogiske verktøy

Lærere og studenter kan bruke denne AI-en til læringsformål, inkludert språkøvelser, informasjonsinnhenting og interaktive veiledningsøkter.

Opprettelse av innhold

Skribenter og markedsførere kan bruke AI til å generere ideer, lage utkast til innhold og til og med redigere og forbedre eksisterende tekster, noe som effektiviserer prosessen med å skape innhold.

Hvem kan bruke Online Llama 3.1 405B Chat

Llama 3.1 405B-chatten er utviklet for et bredt spekter av brukere, inkludert

- Virksomheter: For å forbedre kundeinteraksjon og supporttjenester.

- Lærere og studenter: Som læremiddel og informasjonsressurs.

- Skapere av innhold: For å øke produktiviteten og kreativiteten i innholdsproduksjonen.

- Forskere: For avansert tekstanalyse og språkrelaterte studier.

Alternativer til Llama 3.1 405B-modeller og fordeler og ulemper

| Modell | Fordeler | Ulemper |

|---|---|---|

| GPT-4 | Svært avanserte, omfattende opplæringsdata | Krever betydelige databehandlingsressurser |

| BERT | Utmerket for å forstå sammenhengen i teksten | Ikke like sterk i tekstgenerering |

| T5 | Allsidig og kraftfull både når det gjelder forståelse og generering | Kan være tregere på grunn av kompleksiteten |

| RoBERTa | Forbedret robusthet og ytelse i forhold til BERT | Begrenset til spesifikke oppgaver, mindre allsidig |

Llama 3.1 Modellspesifikasjoner Oversikt

Den Llama 3.1 Modellspesifikasjoner Oversikt gir en detaljert oversikt over de viktigste tekniske spesifikasjonene for ulike Llama 3.1-modeller, inkludert versjonene 8B, 70B og 405B. Denne tabellen fremhever viktige aspekter som treningsdata, parameterstørrelse, inn- og utdatamodaliteter, kontekstlengde og antall tokener, som alle er avgjørende for å forstå prestasjonsmålinger og AI-muligheter av disse modellene. For brukere som ønsker innsikt i Lama-modeller og deres anvendelser i AI-utviklinger denne oversikten et uunnværlig oppslagsverk. Enten du utforsker bruksscenarier eller fordype seg i de tekniske detaljene i online Llama 3.1 405B Chatgir denne tabellen de grunnleggende dataene som trengs for å forstå omfanget og rekkevidden av Meta AIs fremskritt innen modellspesifikasjoner.

| Modell | Opplæringsdata | Parametere | Inndatamodaliteter | Output-modaliteter | Kontekst Lengde | GQA | Antall tokens | Kunnskapsgrense |

|---|---|---|---|---|---|---|---|---|

| 8B | En ny blanding av offentlig tilgjengelige data på nettet. | 8B | Flerspråklig tekst | Flerspråklig tekst og kode | 128k | Ja | 15T+ | desember 2023 |

| 70B | En ny blanding av offentlig tilgjengelige data på nettet. | 70B | Flerspråklig tekst | Flerspråklig tekst og kode | 128k | Ja | 15T+ | desember 2023 |

| 405B | En ny blanding av offentlig tilgjengelige data på nettet. | 405B | Flerspråklig tekst | Flerspråklig tekst og kode | 128k | Ja | 15T+ | desember 2023 |

Miljøpåvirkning og ressursbruk av lama 3.1 Modeller

Den Miljøpåvirkning og ressursbruk av lama 3.1 Modeller tabellen gir en omfattende oversikt over treningstid, strømforbruk, og utslipp av klimagasser knyttet til ulike Llama 3.1-modeller, inkludert versjonene 8B, 70B og 405B. Denne analysen er avgjørende for å forstå det miljømessige fotavtrykket til AI-utvikling prosesser, spesielt for modeller med omfattende tekniske spesifikasjoner og ressursbehov. For de som er interessert i de bredere implikasjonene av å ta i bruk avanserte AI-muligheter som online Llama 3.1 405B Chatkaster denne tabellen lys over prestasjonsmålinger knyttet til bærekraft. Dataene som presenteres, understreker ikke bare de betydelige ressursbehovene til banebrytende Lama-modeller men understreker også viktigheten av å ta hensyn til miljøfaktorer i brukerveiledninger og utviklingspraksis.

| Modell | Opplæringstid (GPU-timer) | Strømforbruk for trening (W) | Stedsbaserte klimagassutslipp (tonn CO2eq) | Markedsbaserte klimagassutslipp (tonn CO2-ekvivalenter) |

|---|---|---|---|---|

| Lama 3.1 8B | 1.46M | 700 | 420 | 0 |

| Llama 3.1 70B | 7.0M | 700 | 2,040 | 0 |

| Llama 3.1 405B | 30.84M | 700 | 8,930 | 0 |

| Totalt | 39.3M | 11,390 | 0 |

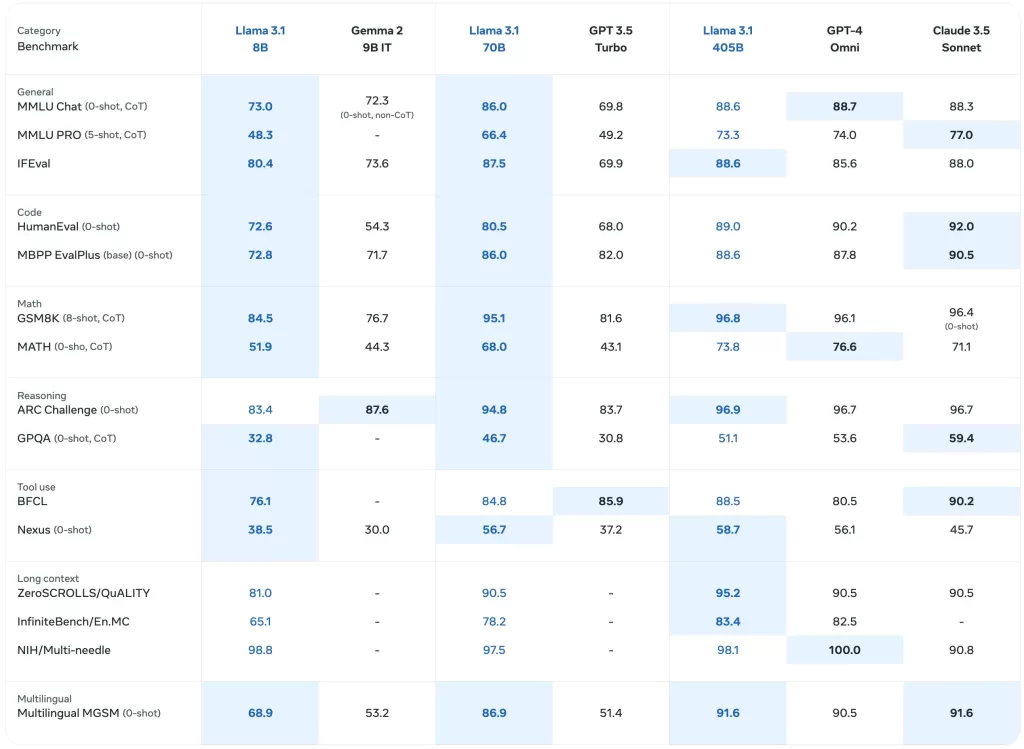

Benchmark-ytelse for Llama 3.1-modeller

Den Benchmark-ytelse for Llama 3.1-modeller tabellen gir en detaljert evaluering av ulike Llama-modeller, inkludert de nyeste Llama 3.1 405Bpå tvers av en rekke prestasjonsmålinger. Denne omfattende analysen inkluderer benchmarks for generelle oppgaver, kunnskapsresonnement, leseforståelse og mer, og gir innsikt i AI-muligheter av disse modellene. For de som er interessert i AI-utvikling og de praktiske anvendelsene av Lama-modellerfremhever denne tabellen de tekniske spesifikasjoner og effektiviteten til hver modell. Den fungerer som en verdifull ressurs for å forstå den komparative ytelsen til online Llama 3.1 405B Chat og dets forgjengere i forskjellige bruksscenarier.

Forutdannede basismodeller

Den Forutdannede basismodeller tabellen presenterer en sammenlignende oversikt over Lama 3 og Llama 3.1 modellene på tvers av flere referanser og måleparametere. Denne delen inneholder data om generell ytelse, kunnskapsresonnement og leseforståelse, noe som gjenspeiler modellenes tekniske spesifikasjoner og AI-muligheter. Med detaljerte resultater for hver modell, inkludert Llama 3.1 405Ber denne tabellen viktig for å vurdere den opprinnelige ytelsen til disse modellene i en rekke ulike sammenhenger. For brukere som utforsker online Llama 3.1 405B Chat og dens effektivitet, gir denne tabellen verdifull innsikt i de grunnleggende referansene som ligger til grunn for disse Lama-modeller.

| Kategori | Referansepunkt | # Shots | Metrisk | Llama 3 8B | Lama 3.1 8B | Llama 3 70B | Llama 3.1 70B | Llama 3.1 405B |

|---|---|---|---|---|---|---|---|---|

| Generelt | MMLU | 5 | macro_avg/acc_char | 66.7 | 66.7 | 79.5 | 79.3 | 85.2 |

| MMLU-Pro (CoT) | 5 | macro_avg/acc_char | 36.2 | 37.1 | 55.0 | 53.8 | 61.6 | |

| AGIEval engelsk | 3-5 | gjennomsnitt/acc_char | 47.1 | 47.8 | 63.0 | 64.6 | 71.6 | |

| CommonSenseQA | 7 | acc_char | 72.6 | 75.0 | 83.8 | 84.1 | 85.8 | |

| Winogrande | 5 | acc_char | – | 60.5 | – | 83.3 | 86.7 | |

| BIG-Bench Hard (CoT) | 3 | gjennomsnitt/em | 61.1 | 64.2 | 81.3 | 81.6 | 85.9 | |

| ARC-Challenge | 25 | acc_char | 79.4 | 79.7 | 93.1 | 92.9 | 96.1 | |

| Kunnskapsmessig resonnement | TriviaQA-Wiki | 5 | em | 78.5 | 77.6 | 89.7 | 89.8 | 91.8 |

| Leseforståelse | SQuAD | 1 | em | 76.4 | 77.0 | 85.6 | 81.8 | 89.3 |

| QuAC (F1) | 1 | f1 | 44.4 | 44.9 | 51.1 | 51.1 | 53.6 | |

| BoolQ | 0 | acc_char | 75.7 | 75.0 | 79.0 | 79.4 | 80.0 | |

| DROP (F1) | 3 | f1 | 58.4 | 59.5 | 79.7 | 79.6 | 84.8 |

Instruksjonsavstemte modeller

Den Instruksjonsavstemte modeller tabellen gir et fokusert blikk på hvordan Llama 3.1 modeller, spesielt de Llama 3.1 405B, når de finjusteres for spesifikke oppgaver. Denne delen inneholder ytelsesmålinger for oppgaver som følger instruksjoner, kodeevaluering og resonnering, og fremhever de forbedrede AI-muligheter oppnås gjennom instruksjonsjustering. Det er en viktig ressurs for å forstå modellspesifikasjoner som driver online Llama 3.1 405B Chatevne til å håndtere komplekse spørringer og oppgaver. Denne tabellen er uvurderlig for dem som utvikler applikasjoner eller lager brukerveiledninger som utnytter Llama 3.1 modellenes avanserte funksjoner.

| Kategori | Referansepunkt | # Shots | Metrisk | Llama 3 8B Instruksjon | Llama 3.1 8B Instruksjon | Llama 3 70B Instruksjon | Llama 3.1 70B Instruksjon | Llama 3.1 405B Instruksjon |

|---|---|---|---|---|---|---|---|---|

| Generelt | MMLU | 5 | macro_avg/acc | 68.5 | 69.4 | 82.0 | 83.6 | 87.3 |

| MMLU (CoT) | 0 | macro_avg/acc | 65.3 | 73.0 | 80.9 | 86.0 | 88.6 | |

| MMLU-Pro (CoT) | 5 | micro_avg/acc_char | 45.5 | 48.3 | 63.4 | 66.4 | 73.3 | |

| IFEval | – | – | 76.8 | 80.4 | 82.9 | 87.5 | 88.6 | |

| Begrunnelse | ARC-C | 0 | acc | 82.4 | 83.4 | 94.4 | 94.8 | 96.9 |

| GPQA | 0 | em | 34.6 | 30.4 | 39.5 | 41.7 | 50.7 | |

| Kode | HumanEval | 0 | pass@1 | 60.4 | 72.6 | 81.7 | 80.5 | 89.0 |

| MBPP ++ basisversjon | 0 | pass@1 | 70.6 | 72.8 | 82.5 | 86.0 | 88.6 | |

| Multipl-E HumanEval | 0 | pass@1 | – | 50.8 | – | 65.5 | 75.2 | |

| Multipl-E MBPP | 0 | pass@1 | – | 52.4 | – | 62.0 | 65.7 | |

| Matematikk | GSM-8K (CoT) | 8 | em_maj1@1 | 80.6 | 84.5 | 93.0 | 95.1 | 96.8 |

| MATH (CoT) | 0 | final_em | 29.1 | 51.9 | 51.0 | 68.0 | 73.8 | |

| Bruk av verktøy | API-Bank | 0 | acc | 48.3 | 82.6 | 85.1 | 90.0 | 92.0 |

| BFCL | 0 | acc | 60.3 | 76.1 | 83.0 | 84.8 | 88.5 | |

| Gorilla Benchmark API Bench | 0 | acc | 1.7 | 8.2 | 14.7 | 29.7 | 35.3 | |

| Nexus (0-skudd) | 0 | macro_avg/acc | 18.1 | 38.5 | 47.8 | 56.7 | 58.7 | |

| Flerspråklig | Flerspråklig MGSM (CoT) | 0 | em | – | 68.9 | – | 86.9 | 91.6 |

Flerspråklige referanseverdier

Den Flerspråklige referanseverdier tabellen viser ytelsen til Llama 3.1 modeller på ulike språk, blant annet portugisisk, spansk, italiensk, tysk, fransk, hindi og thai. Denne delen illustrerer modellenes evne til å håndtere flerspråklige inndata og gir ytelsesmålinger som er spesifikke for hvert språk. For de som er interessert i å ta i bruk online Llama 3.1 405B Chat i ulike språklige kontekster, fremhever denne tabellen de AI-muligheter og tekniske spesifikasjoner som gjør disse modellene allsidige på tvers av ulike språk. Den er en viktig ressurs for å forstå hvor godt Lama-modeller opptre i global bruksscenarier og for å utforme effektive brukerveiledninger.

| Kategori | Referansepunkt | Språk | Lama 3.1 8B | Llama 3.1 70B | Llama 3.1 405B |

|---|---|---|---|---|---|

| Generelt | MMLU (5-skudd, macro_avg/acc) | Portugisisk | 62.12 | 80.13 | 84.95 |

| Spansk | 62.45 | 80.05 | 85.08 | ||

| Italiensk | 61.63 | 80.4 | 85.04 | ||

| Tysk | 60.59 | 79.27 | 84.36 | ||

| Fransk | 62.34 | 79.82 | 84.66 | ||

| Hindi | 50.88 | 74.52 | 80.31 | ||

| Thai | 50.32 | 72.95 | 78.21 |

Modellevalueringer med referanseverdier