ラマ 3.1 405B ウェブ検索付きチャット

試す Reflection 70B チャット - Llama 3.1 ベース

言語サポート

英語:母国語です!

スペイン語僕もスペイン語で会話するよ!

フランス語:はい、フランス語が話せます!

ドイツ語:ああ、ドイツ語も話せるよ!

イタリア語:チャオ!イタリア語で話すよ!

ポルトガル語:オラ!僕もポルトガル語を話すよ!

オランダ語:こんにちは!僕はオランダ語で話してるんだ!

ロシア語:Привет!僕も "Привет "を話すよ!

中国語(簡体字)と(繁体字)-ああ、僕も北京語を話すよ!

日本語:コンニチハ!僕も会話するよ!

韓国語ハングルも話せるよ!

アラビア語:مرحبا!僕もالعربيةで会話するよ!

ヘブライ語: שלום!僕もעבריתを話すよ!

* インターネットの速度によっては、モデルをオンラインで読み込むのに数秒かかる場合があります。

オンラインラマ 3.1 チャット|インストラクターモード

ラマ3.1のよくある質問

1.Meta Llama 3.1 405Bとは何ですか?

Meta Llama 3.1は、4,050億ものパラメータを誇るMeta社の最新言語モデルです。テキスト生成、言語翻訳、会話システムなど、自然言語処理の高度な機能を提供します。

Llama 3.1を使う最も簡単な方法は以下の通りです。 ラマAIオンライン

2.Meta Llama 3.1へのアクセス方法を教えてください。

Meta Llama 3.1とそのリソースには、公式ウェブサイトからアクセスできます。 ラマ.メタ.コム にある包括的なモデルカードと使用説明書をご覧ください。 メタのGitHubリポジトリ.

3.Meta Llama 3.1は以前のバージョンと何が違うのですか?

Meta Llama 3.1は4,050億のパラメータを備えており、利用可能な最も強力な言語モデルの一つとなっています。自然言語理解と生成の精度と効率が向上しています。

4.Meta Llama 3.1 405Bの主な用途は?

Meta Llama 3.1は、テキスト生成、言語翻訳、会話システムなど、さまざまなアプリケーション向けに設計されており、開発者や研究者にとって汎用性の高いツールとなっている。

5.Meta Llama 3.1は自然言語処理タスクをどのように改善しますか?

Meta Llama 3.1は、豊富なパラメータと高度なアーキテクチャにより、より正確で文脈に即した出力を提供し、自然言語処理タスクのパフォーマンスを向上させます。

6.Meta Llama 3.1のモデルカードはどこにありますか?

Meta Llama 3.1のモデルカードはMetaの公式GitHubリポジトリにあります。モデルの機能、使用ガイドライン、技術仕様に関する詳細な情報が含まれています。

7.Meta Llama 3.1はオープンソースで利用できますか?

はい、Meta Llama 3.1はオープンソースとして利用可能です。Metaは、開発者がモデルを効果的に統合し、活用するための包括的なリソースとドキュメントを提供しています。

8.Meta Llama 3.1をオンラインチャットに使うにはどうしたらいいですか?

Meta Llama 3.1は、オンラインチャットアプリケーションに統合して、会話能力を強化することができます。高度な自然言語理解を活用して、よりインタラクティブで応答性の高いチャットボットを作成できます。

9.Meta Llama 3.1の使い方を学ぶために、どのようなリソースがありますか?

メタ社は、詳細なモデルカード、使用方法、使用例など、豊富なリソースを提供している。 GitHubリポジトリ.さらに、Meta Llama 3.1を探索するための最良のツールは、次のとおりです。 https://llamaai.online/.

10.Meta Llama 3.1は言語翻訳タスクに使えますか?

Meta Llama 3.1は、言語翻訳タスクに非常に効果的です。その高度な自然言語処理機能により、さまざまな言語にわたって、正確で文脈に適した翻訳が保証されます。

オンラインラマ3.1 405Bチャット:徹底ガイド

Meta Llama 3.1は、4,050億ものパラメータを誇るMeta社の最新言語モデルです。テキスト生成、言語翻訳、会話システムなど、自然言語処理の高度な機能を提供します。

目次

- Llama 3.1 405Bとは何ですか?

- メタAIにおけるラマ3.1 405Bの重要性

- オンラインラマ3.1 405Bチャットの利点

- オンラインラマ3.1 405Bチャットの使用に適したシナリオ

- 誰がオンラインラマ3.1 405Bチャットを使用することができます

- ラマ3.1 405Bの代替モデルと長所と短所

Llama 3.1 405Bとは何ですか?

Llama 3.1 405Bは、Meta AIのLlamaシリーズの最新版で、自然言語処理と理解において大きな進歩を誇っています。このモデルは4,050億ものパラメータを備えており、これまでで最もパワフルなAIモデルのひとつとなっている。主な用途は、言語翻訳、会話AI、高度なテキスト分析などです。

メタAIにおけるラマ3.1 405Bの重要性

Llama 3.1 405Bモデルは、AI能力の限界を押し広げるというMeta AIの戦略の要です。その膨大なパラメーターセットは、次世代AIアプリケーションの開発に不可欠な、よりニュアンスに富んだ正確な言語処理を可能にします。このモデルは、シンプルなチャットボットから複雑なデータ分析ツールまで、幅広いタスクをサポートし、Meta AIのイノベーションへのコミットメントを強調しています。

オンラインラマ3.1 405Bチャットの利点

強化されたパフォーマンス

オンラインLlama 3.1 405Bチャットは、応答精度とスピードの面で比類のないパフォーマンスを提供します。ユーザーは、人間のようなテキストを理解し、生成することができる、非常に応答性の高いインテリジェントな会話パートナーの恩恵を受けることができます。

アクセシビリティ

オンライン・インターフェースを提供することで、Meta AIは、ユーザーが大規模なハードウェアや技術的な専門知識を必要とすることなく、Llama 3.1 405Bの強力な機能にアクセスできることを保証します。これにより、高度なAI機能へのアクセスが民主化されます。

汎用性

このオンラインチャットプラットフォームは、カスタマーサービス、教育、コンテンツ制作など、様々な業界で使用することができます。文脈を理解し、関連性のある応答を生成する能力により、専門家にとっても愛好家にとっても価値あるツールとなっています。

オンラインラマ3.1 405Bチャットの使用に適したシナリオ

カスタマーサポート

企業は、オンライン Llama 3.1 405B チャットを活用することで、効率的かつ効果的なカスタマーサポートを実現し、正確な回答を提供しながら、同時に大量の問い合わせを処理することができます。

教育ツール

教育者や学生は、言語練習、情報検索、対話型個別指導セッションなどの学習目的にこのAIを使用することができる。

コンテンツ制作

ライターやマーケティング担当者は、AIを活用してアイデアを生み出し、コンテンツを下書きし、さらには既存の文章を編集・改善することで、コンテンツ作成プロセスを効率化することができる。

誰がオンラインラマ3.1 405Bチャットを使用することができます

オンラインLlama 3.1 405Bチャットは、以下のような幅広いユーザー向けに設計されています:

- ビジネス 顧客との対話とサポートサービスの向上

- 教育者と学生: 学習教材および情報資源として。

- コンテンツ・クリエーター コンテンツ制作の生産性と創造性を高める。

- 研究者たち 高度なテキスト分析や言語関連の研究を行うため。

ラマ3.1 405Bの代替モデルと長所と短所

| モデル | 長所 | 短所 |

|---|---|---|

| GPT-4 | 高度で豊富なトレーニングデータ | 多大な計算資源を必要とする |

| バート | テキストの文脈を理解するのに優れている | テキスト生成にはそれほど強くない |

| T5 | 理解も生成も万能でパワフル | 複雑なため時間がかかる |

| ロベルタ | BERTを上回るロバスト性と性能の向上 | 特定の作業に限定され、汎用性が低い |

ラマ 3.1 モデル仕様概要

について ラマ 3.1 モデル仕様概要 には、8B、70B、405Bの各バージョンを含む、さまざまなLlama 3.1モデルの主要な技術仕様の詳細な内訳が記載されています。この表は、学習データ、パラメータ・サイズ、入力と出力のモダリティ、コンテキストの長さ、トークン数など、Llama 3.1モデルを理解する上で極めて重要な要素を取り上げています。 パフォーマンス測定基準 そして AI能力 これらのモデルのについての洞察を求めるユーザーにとって ラマモデル およびその応用 AI開発この概説書は必要不可欠な参考資料となる。あなたが 利用シーン の技術的な複雑さを掘り下げることもできる。 オンラインラマ3.1 405Bチャットこの表は、Meta AIの進歩の規模と範囲を把握するために必要な基礎データを提供するものである。 モデル仕様.

| モデル | トレーニングデータ | パラメータ | 入力モダリティ | 出力モダリティ | コンテキストの長さ | GQA | トークン数 | 知識カットオフ |

|---|---|---|---|---|---|---|---|---|

| 8B | 一般に入手可能なオンラインデータの新しい組み合わせ。 | 8B | 多言語テキスト | 多言語テキストとコード | 128k | はい | 15T+ | 2023年12月 |

| 70B | 一般に入手可能なオンラインデータの新しい組み合わせ。 | 70B | 多言語テキスト | 多言語テキストとコード | 128k | はい | 15T+ | 2023年12月 |

| 405B | 一般に入手可能なオンラインデータの新しい組み合わせ。 | 405B | 多言語テキスト | 多言語テキストとコード | 128k | はい | 15T+ | 2023年12月 |

ラマによる環境影響と資源利用 3.1 モデル

について ラマによる環境影響と資源利用 3.1 モデル 表は、その包括的な内容である。 トレーニング時間, 消費電力そして 温室効果ガス排出量 8B、70B、405Bの各バージョンを含む、さまざまなLlama 3.1モデルに関連する。の環境フットプリントを理解する上で、この分析は極めて重要である。 AI開発 特に広範なプロセスを持つモデルの場合 技術仕様 とリソース要件。高度な技術を導入することの広範な意味合いに興味をお持ちの方は、以下の記事をご覧いただきたい。 AI能力 のように オンラインラマ3.1 405Bチャットこの表は、このような状況について明らかにしている。 パフォーマンス測定基準 持続可能性に関するものである。提示されたデータは、最先端技術に多大な資源が必要であることを強調している。 ラマモデル において環境要因を考慮することの重要性を強調している。 ユーザーガイド と開発プラクティス。

| モデル | トレーニング時間(GPU時間) | トレーニング消費電力 (W) | 所在地ベースの温室効果ガス排出量(トン-CO2eq) | 市場ベースの温室効果ガス排出量(トン-CO2eq) |

|---|---|---|---|---|

| ラマ 3.1 8B | 1.46M | 700 | 420 | 0 |

| ラマ 3.1 70B | 7.0M | 700 | 2,040 | 0 |

| ラマ 3.1 405B | 30.84M | 700 | 8,930 | 0 |

| 合計 | 39.3M | 11,390 | 0 |

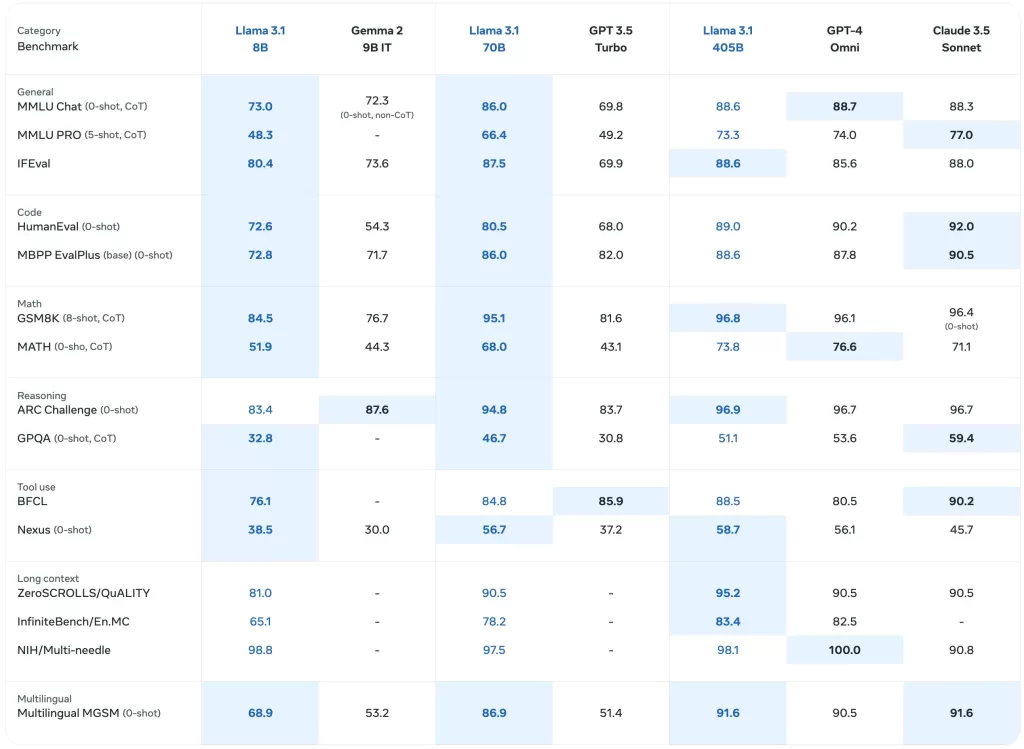

Llama 3.1モデルのベンチマーク性能

について Llama 3.1モデルのベンチマーク性能 この表では、最新のモデルを含むラマ・モデルの詳細な評価を掲載している。 ラマ 3.1 405B様々な パフォーマンス測定基準.この包括的な分析には、一般的なタスク、知識推論、読解力などのベンチマークが含まれ、以下のような洞察が得られます。 AI能力 これらのモデルのご興味のある方は AI開発 を実際に応用している。 ラマモデルこの表では、以下の項目を取り上げている。 技術仕様 そして各モデルの有効性。の比較性能を理解するための貴重な資料となる。 オンラインラマ3.1 405Bチャット とその前身である様々な 利用シーン.

ベース学習済みモデル

について ベース学習済みモデル の比較の概要を示す。 ラマ3 そして ラマ 3.1 モデルについて、いくつかのベンチマークと測定基準で評価した。このセクションには、一般的なパフォーマンス、知識推論、読解力に関するデータが含まれており、モデルのパフォーマンスを反映している。 技術仕様 そして AI能力.を含む各モデルの詳細な結果 ラマ 3.1 405Bこの表は、様々な文脈におけるこれらのモデルの初期性能を評価するために不可欠である。ユーザーにとって オンラインラマ3.1 405Bチャット この表は、これらのベンチマークを支える基礎的なベンチマークとその効果について、貴重な洞察を与えてくれる。 ラマモデル.

| カテゴリー | ベンチマーク | #ショット | メートル | ラマ3 8B | ラマ 3.1 8B | ラマ3 70B | ラマ 3.1 70B | ラマ 3.1 405B |

|---|---|---|---|---|---|---|---|---|

| 一般 | MMLU | 5 | マクロ_avg/acc_char | 66.7 | 66.7 | 79.5 | 79.3 | 85.2 |

| MMLUプロ(CoT) | 5 | マクロ_avg/acc_char | 36.2 | 37.1 | 55.0 | 53.8 | 61.6 | |

| AGIEval英語 | 3-5 | 平均/acc_char | 47.1 | 47.8 | 63.0 | 64.6 | 71.6 | |

| コモンセンスQA | 7 | acc_char | 72.6 | 75.0 | 83.8 | 84.1 | 85.8 | |

| ウィノグランド | 5 | acc_char | – | 60.5 | – | 83.3 | 86.7 | |

| BIGベンチ・ハード(CoT) | 3 | 平均/平均 | 61.1 | 64.2 | 81.3 | 81.6 | 85.9 | |

| アーク・チャレンジ | 25 | acc_char | 79.4 | 79.7 | 93.1 | 92.9 | 96.1 | |

| 知識推論 | トリビアQAウィキ | 5 | エム | 78.5 | 77.6 | 89.7 | 89.8 | 91.8 |

| 読解力 | スクワッド | 1 | エム | 76.4 | 77.0 | 85.6 | 81.8 | 89.3 |

| クアック(F1) | 1 | f1 | 44.4 | 44.9 | 51.1 | 51.1 | 53.6 | |

| ブールキュー | 0 | acc_char | 75.7 | 75.0 | 79.0 | 79.4 | 80.0 | |

| ドロップ (F1) | 3 | f1 | 58.4 | 59.5 | 79.7 | 79.6 | 84.8 |

インストラクション・チューンド・モデル

について インストラクション・チューンド・モデル この表では、「どのような方法で ラマ 3.1 モデル、特に ラマ 3.1 405Bまた、特定のタスク用に微調整された場合のパフォーマンスも紹介します。このセクションには、命令追従タスク、コード評価、推論に関するパフォーマンス・メトリクスが含まれ、以下の強化点が強調されている。 AI能力 インストラクション・チューニングによって達成される。を理解するための重要なリソースである。 モデル仕様 その原動力は オンラインラマ3.1 405Bチャットの複雑なクエリーやタスクを処理する能力である。このテーブルは、アプリケーションを開発したり ユーザーガイド を活用している。 ラマ 3.1 モデルの高度な能力

| カテゴリー | ベンチマーク | #ショット | メートル | ラマ3 8B インストラクター | ラマ3.1 8Bインストラクター | ラマ3 70B インストラクター | ラマ3.1 70Bインストラクター | ラマ3.1 405Bインストラクター |

|---|---|---|---|---|---|---|---|---|

| 一般 | MMLU | 5 | マクロ_avg/acc | 68.5 | 69.4 | 82.0 | 83.6 | 87.3 |

| MMLU (CoT) | 0 | マクロ_avg/acc | 65.3 | 73.0 | 80.9 | 86.0 | 88.6 | |

| MMLUプロ(CoT) | 5 | マイクロアベレージ/acc_char | 45.5 | 48.3 | 63.4 | 66.4 | 73.3 | |

| IFEval | – | – | 76.8 | 80.4 | 82.9 | 87.5 | 88.6 | |

| 推論 | ARC-C | 0 | acc | 82.4 | 83.4 | 94.4 | 94.8 | 96.9 |

| ジーピーキューエー | 0 | エム | 34.6 | 30.4 | 39.5 | 41.7 | 50.7 | |

| コード | ヒューマンエバール | 0 | パス@1 | 60.4 | 72.6 | 81.7 | 80.5 | 89.0 |

| MBPP ++ベースバージョン | 0 | パス@1 | 70.6 | 72.8 | 82.5 | 86.0 | 88.6 | |

| Multipl-E HumanEval | 0 | パス@1 | – | 50.8 | – | 65.5 | 75.2 | |

| マルチプルE MBPP | 0 | パス@1 | – | 52.4 | – | 62.0 | 65.7 | |

| 数学 | GSM-8K (CoT) | 8 | em_maj1@1 | 80.6 | 84.5 | 93.0 | 95.1 | 96.8 |

| 数学 (CoT) | 0 | final_em | 29.1 | 51.9 | 51.0 | 68.0 | 73.8 | |

| ツール使用 | APIバンク | 0 | acc | 48.3 | 82.6 | 85.1 | 90.0 | 92.0 |

| BFCL | 0 | acc | 60.3 | 76.1 | 83.0 | 84.8 | 88.5 | |

| ゴリラ・ベンチマークAPIベンチ | 0 | acc | 1.7 | 8.2 | 14.7 | 29.7 | 35.3 | |

| ネクサス(0ショット) | 0 | マクロ_avg/acc | 18.1 | 38.5 | 47.8 | 56.7 | 58.7 | |

| 多言語 | 多言語MGSM(CoT) | 0 | エム | – | 68.9 | – | 86.9 | 91.6 |

多言語ベンチマーク

について 多言語ベンチマーク のパフォーマンスを紹介する。 ラマ 3.1 ポルトガル語、スペイン語、イタリア語、ドイツ語、フランス語、ヒンディー語、タイ語など、さまざまな言語のモデル。このセクションでは、多言語入力を処理するモデルの能力を説明し、各言語に特化したパフォーマンス・メトリクスを提供します。モデルの導入に興味のある方は オンラインラマ3.1 405Bチャット 多様な言語的コンテクストにおける AI能力 そして 技術仕様 これらのモデルを異なる言語間で汎用性のあるものにしている。を理解するための重要な資料である。 ラマモデル グローバルでのパフォーマンス 利用シーン そして、効果的な ユーザーガイド.

| カテゴリー | ベンチマーク | 言語 | ラマ 3.1 8B | ラマ 3.1 70B | ラマ 3.1 405B |

|---|---|---|---|---|---|

| 一般 | MMLU(5ショット、マクロ/AVG/ACC) | ポルトガル語 | 62.12 | 80.13 | 84.95 |

| スペイン語 | 62.45 | 80.05 | 85.08 | ||

| イタリア語 | 61.63 | 80.4 | 85.04 | ||

| ドイツ語 | 60.59 | 79.27 | 84.36 | ||

| フランス語 | 62.34 | 79.82 | 84.66 | ||

| ヒンディー語 | 50.88 | 74.52 | 80.31 | ||

| タイ | 50.32 | 72.95 | 78.21 |

ベンチマークによるモデル評価