Llama 3.1 405B Chat avec recherche sur le Web

Essayer Reflection 70B Chat - Basé sur Llama 3.1

Soutien linguistique

Anglais: Ma langue maternelle !

EspagnolJe converse aussi en espagnol !

Français: Oui, je parle Français, matey !

Allemand: Aye, ich spreche Deutsch, too !

Italien: Ciao ! Je parle en italien, mon pote !

Portugais: Olá ! Je parle aussi le portugais !

Néerlandais: Hallo ! Je converse en néerlandais, mon ami !

Russie: Привет ! Je parle Русский, aussi !

ChinoisLes langues : (simplifié) et (traditionnel) - Oui, je parle aussi le mandarin !

Japonais: Konnichiwa ! Moi aussi, je converse !

Coréen: - Oui, je parle aussi le Hangul !

L'arabe: مرحبا ! Je parle aussi en العربية !

Hébreu: שלום ! Je parle aussi עברית !

* Le chargement du modèle en ligne peut prendre quelques secondes, en fonction de votre vitesse d'accès à Internet.

Online Llama 3.1 Chat | Instruct Mode

Foire aux questions pour Llama 3.1

1. Qu'est-ce que Meta Llama 3.1 405B ?

Meta Llama 3.1 est le dernier modèle linguistique de Meta, avec 405 milliards de paramètres. Il offre des capacités avancées de traitement du langage naturel, y compris la génération de textes, la traduction et les systèmes de conversation.

La façon la plus simple d'utiliser Llama 3.1 est la suivante Llama AI Online

2. Comment puis-je accéder à Meta Llama 3.1 ?

Vous pouvez accéder à Meta Llama 3.1 et à ses ressources via le site officiel llama.meta.com et consultez la fiche modèle complète et les instructions d'utilisation sur le site Dépôt GitHub de Meta.

3. En quoi Meta Llama 3.1 est-il différent des versions précédentes ?

Meta Llama 3.1 dispose de 405 milliards de paramètres, ce qui en fait l'un des modèles linguistiques les plus puissants disponibles. Il offre une précision et une efficacité accrues en matière de compréhension et de génération de langage naturel.

4. Quelles sont les principales applications de Meta Llama 3.1 405B ?

Meta Llama 3.1 est conçu pour diverses applications, notamment la génération de textes, la traduction de langues et les systèmes de conversation, ce qui en fait un outil polyvalent pour les développeurs et les chercheurs.

5. Comment Meta Llama 3.1 améliore-t-il les tâches de traitement du langage naturel ?

Grâce à ses paramètres étendus et à son architecture avancée, Meta Llama 3.1 fournit des résultats plus précis et plus pertinents sur le plan contextuel, améliorant ainsi les performances des tâches de traitement du langage naturel.

6. Où puis-je trouver la carte de modèle pour Meta Llama 3.1 ?

La fiche du modèle pour Meta Llama 3.1 peut être trouvée sur le dépôt officiel GitHub de Meta. Elle comprend des informations détaillées sur les capacités du modèle, des conseils d'utilisation et des spécifications techniques.

7. Meta Llama 3.1 est-il disponible en open-source ?

Oui, Meta Llama 3.1 est disponible pour une utilisation libre. Meta fournit des ressources et une documentation complètes pour aider les développeurs à intégrer et à utiliser le modèle de manière efficace.

8. Comment puis-je utiliser Meta Llama 3.1 pour des applications de chat en ligne ?

Meta Llama 3.1 peut être intégré dans des applications de chat en ligne pour améliorer les capacités de conversation. Vous pouvez tirer parti de sa compréhension avancée du langage naturel pour créer des chatbots plus interactifs et plus réactifs.

9. Quelles sont les ressources disponibles pour apprendre à utiliser Meta Llama 3.1 ?

Meta propose des ressources étendues, y compris une fiche modèle détaillée, des instructions d'utilisation et des exemples sur son site Web. Dépôt GitHub. En outre, le meilleur outil pour explorer Meta Llama 3.1 est l'outil suivant https://llamaai.online/.

10. Meta Llama 3.1 peut-il être utilisé pour des tâches de traduction ?

Oui, Meta Llama 3.1 est très efficace pour les tâches de traduction. Ses capacités avancées de traitement du langage naturel garantissent des traductions précises et adaptées au contexte dans différentes langues.

Online Llama 3.1 405B Chat : Un guide approfondi

Meta Llama 3.1 est le dernier modèle linguistique de Meta, avec 405 milliards de paramètres. Il offre des capacités avancées de traitement du langage naturel, y compris la génération de textes, la traduction et les systèmes de conversation.

Table des matières

- Qu'est-ce que Llama 3.1 405B ?

- Importance de Llama 3.1 405B pour Meta AI

- Avantages de l'utilisation de Online Llama 3.1 405B Chat

- Scénarios appropriés pour l'utilisation du chat en ligne Llama 3.1 405B

- Qui peut utiliser Online Llama 3.1 405B Chat

- Alternatives aux modèles Llama 3.1 405B et avantages et inconvénients

Qu'est-ce que Llama 3.1 405B ?

Llama 3.1 405B est la dernière itération de la série Llama de Meta AI, qui présente des avancées significatives en matière de traitement et de compréhension du langage naturel. Ce modèle comporte 405 milliards de paramètres, ce qui en fait l'un des modèles d'IA les plus puissants à ce jour. Ses principales applications sont la traduction linguistique, l'IA conversationnelle et l'analyse de texte avancée.

Importance de Llama 3.1 405B pour Meta AI

Le modèle Llama 3.1 405B est une pierre angulaire de la stratégie de Meta AI visant à repousser les limites des capacités de l'IA. Son vaste ensemble de paramètres permet un traitement du langage plus nuancé et plus précis, ce qui est crucial pour le développement d'applications d'IA de nouvelle génération. Ce modèle prend en charge un large éventail de tâches, des simples chatbots aux outils d'analyse de données complexes, soulignant ainsi l'engagement de Meta AI en faveur de l'innovation.

Avantages de l'utilisation de Online Llama 3.1 405B Chat

Amélioration des performances

Le chat en ligne Llama 3.1 405B offre des performances inégalées en termes de précision et de rapidité des réponses. Les utilisateurs bénéficient d'un partenaire conversationnel intelligent et très réactif, capable de comprendre et de générer des textes de type humain.

Accessibilité

En fournissant une interface en ligne, Meta AI permet aux utilisateurs d'accéder aux puissantes fonctionnalités de Llama 3.1 405B sans avoir besoin d'un matériel ou d'une expertise technique importants. Cela démocratise l'accès aux capacités avancées de l'IA.

Polyvalence

La plateforme de chat en ligne peut être utilisée dans divers secteurs, notamment le service à la clientèle, l'éducation et la création de contenu. Sa capacité à comprendre et à générer des réponses contextuelles pertinentes en fait un outil précieux pour les professionnels comme pour les passionnés.

Scénarios appropriés pour l'utilisation du chat en ligne Llama 3.1 405B

Soutien à la clientèle

Les entreprises peuvent tirer parti du chat en ligne de Llama 3.1 405B pour une assistance à la clientèle efficace et efficiente, en traitant simultanément un grand nombre de demandes tout en fournissant des réponses précises.

Outils pédagogiques

Les éducateurs et les étudiants peuvent utiliser cette IA à des fins d'apprentissage, notamment pour la pratique des langues, la recherche d'informations et les séances de tutorat interactives.

Création de contenu

Les rédacteurs et les spécialistes du marketing peuvent utiliser l'IA pour générer des idées, rédiger des contenus et même éditer et améliorer des textes existants, rationalisant ainsi le processus de création de contenu.

Qui peut utiliser Online Llama 3.1 405B Chat

Le chat en ligne Llama 3.1 405B est conçu pour un large éventail d'utilisateurs, notamment :

- Entreprises : Pour améliorer l'interaction avec les clients et les services d'assistance.

- Éducateurs et étudiants : En tant qu'aide à l'apprentissage et source d'information.

- Créateurs de contenu : Améliorer la productivité et la créativité dans la génération de contenu.

- Chercheurs : Pour effectuer des analyses de texte avancées et des études linguistiques.

Alternatives aux modèles Llama 3.1 405B et avantages et inconvénients

| Modèle | Pour | Cons |

|---|---|---|

| GPT-4 | Données de formation très avancées et très complètes | Nécessite d'importantes ressources informatiques |

| BERT | Excellent pour comprendre le contexte d'un texte | Moins performant dans la génération de textes |

| T5 | Polyvalent et puissant, tant au niveau de la compréhension que de la génération | Peut être plus lent en raison de sa complexité |

| RoBERTa | Robustesse et performance améliorées par rapport à BERT | Limité à des tâches spécifiques, moins polyvalent |

Aperçu des spécifications du modèle Llama 3.1

Les Aperçu des spécifications du modèle Llama 3.1 fournit une ventilation détaillée des principales spécifications techniques des différents modèles de lama 3.1, y compris les versions 8B, 70B et 405B. Ce tableau met en évidence des aspects cruciaux tels que les données d'entraînement, la taille des paramètres, les modalités d'entrée et de sortie, la longueur du contexte et le nombre de jetons, qui sont tous essentiels pour comprendre le fonctionnement des modèles Llama. les mesures de performance et Capacités en matière d'IA de ces modèles. Pour les utilisateurs qui cherchent à comprendre Modèles de lamas et leurs applications dans Développement de l'IACette vue d'ensemble constitue une référence essentielle. Que vous exploriez scénarios d'utilisation ou de se plonger dans les subtilités techniques des online Llama 3.1 405B ChatCe tableau fournit les données de base nécessaires pour saisir l'ampleur et la portée des avancées de Meta AI dans les domaines suivants spécifications du modèle.

| Modèle | Données de formation | Params | Modalités d'entrée | Modalités de sortie | Contexte Longueur | GQA | Nombre de jetons | Critères d'évaluation des connaissances |

|---|---|---|---|---|---|---|---|---|

| 8B | Un nouveau mélange de données en ligne accessibles au public. | 8B | Texte multilingue | Texte et code multilingues | 128k | Oui | 15T+ | Décembre 2023 |

| 70B | Un nouveau mélange de données en ligne accessibles au public. | 70B | Texte multilingue | Texte et code multilingues | 128k | Oui | 15T+ | Décembre 2023 |

| 405B | Un nouveau mélange de données en ligne accessibles au public. | 405B | Texte multilingue | Texte et code multilingues | 128k | Oui | 15T+ | Décembre 2023 |

Impact environnemental et utilisation des ressources par les lamas 3.1 Modèles

Les Impact environnemental et utilisation des ressources par les lamas 3.1 Modèles offre une vue d'ensemble de la temps de formation, la consommation d'énergieet émissions de gaz à effet de serre associée aux différents modèles de lama 3.1, y compris les versions 8B, 70B et 405B. Cette analyse est cruciale pour comprendre l'empreinte environnementale de l'élevage de lamas. Développement de l'IA particulièrement pour les modèles avec un grand nombre de spécifications techniques et les besoins en ressources. Pour ceux qui s'intéressent aux implications plus larges du déploiement d'applications avancées de l Capacités en matière d'IA comme le online Llama 3.1 405B ChatCe tableau met en lumière les les mesures de performance liées à la durabilité. Les données présentées soulignent non seulement les besoins considérables en ressources des projets de pointe, mais aussi la nécessité d'améliorer la qualité de l'eau et de l'air. Modèles de lamas mais souligne également l'importance de prendre en compte les facteurs environnementaux dans le cadre de l'évaluation de la qualité de l'eau. guides de l'utilisateur et les pratiques de développement.

| Modèle | Durée de la formation (heures GPU) | Formation Consommation électrique (W) | Émissions de gaz à effet de serre liées à la localisation (tonnes de CO2eq) | Émissions de gaz à effet de serre basées sur le marché (tonnes CO2eq) |

|---|---|---|---|---|

| Llama 3.1 8B | 1.46M | 700 | 420 | 0 |

| Llama 3.1 70B | 7.0M | 700 | 2,040 | 0 |

| Llama 3.1 405B | 30.84M | 700 | 8,930 | 0 |

| Total | 39.3M | 11,390 | 0 |

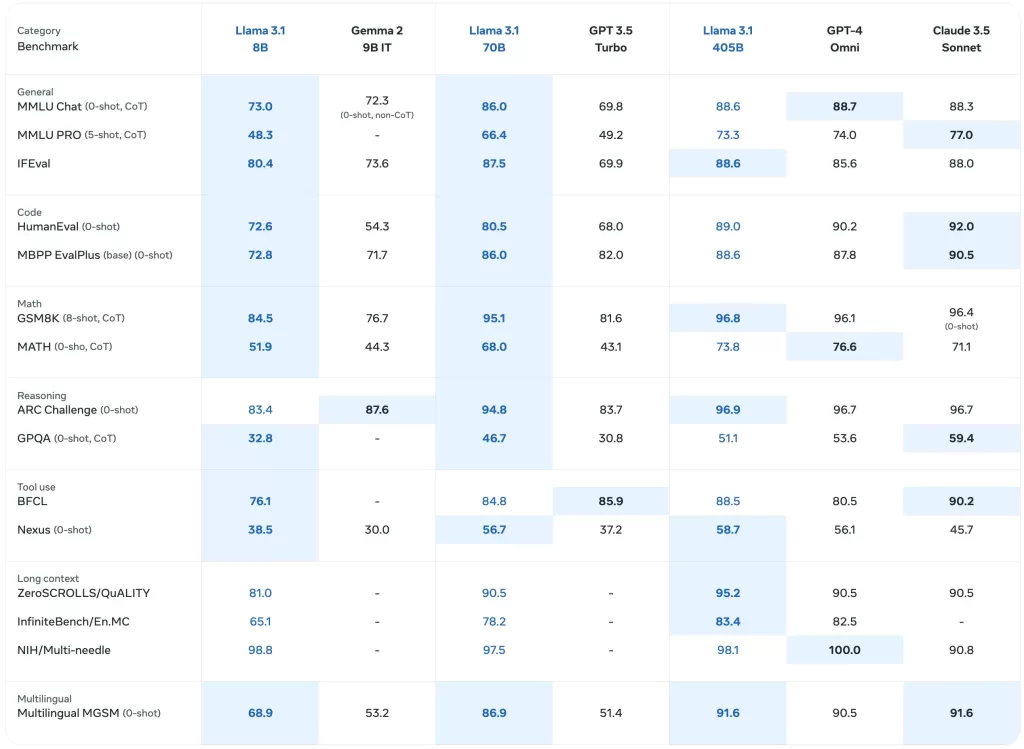

Performances de référence des modèles Llama 3.1

Les Performances de référence des modèles Llama 3.1 Le tableau présente une évaluation détaillée des différents modèles de lamas, y compris les plus récents. Llama 3.1 405BLes résultats de l'enquête sont présentés dans une série d'études de cas sur le thème de la santé. les mesures de performance. Cette analyse complète comprend des critères de référence pour les tâches générales, le raisonnement cognitif, la compréhension de la lecture, etc. Capacités en matière d'IA de ces modèles. Pour les personnes intéressées par Développement de l'IA et les applications concrètes de la Modèles de lamasCe tableau met en évidence les spécifications techniques et l'efficacité de chaque modèle. Il s'agit d'une ressource précieuse pour comprendre les performances comparées des online Llama 3.1 405B Chat et ses prédécesseurs dans divers scénarios d'utilisation.

Base Modèles pré-entraînés

Les Base Modèles pré-entraînés Le tableau présente une vue d'ensemble comparative des Lama 3 et Llama 3.1 sur plusieurs critères de référence et de mesure. Cette section comprend des données sur les performances générales, le raisonnement sur les connaissances et la compréhension de la lecture, qui reflètent les performances des modèles. spécifications techniques et Capacités en matière d'IA. Avec des résultats détaillés pour chaque modèle, y compris les Llama 3.1 405BCe tableau est essentiel pour évaluer les performances initiales de ces modèles dans divers contextes. Pour les utilisateurs qui explorent online Llama 3.1 405B Chat et son efficacité, ce tableau offre des indications précieuses sur les critères de référence fondamentaux qui sous-tendent ces Modèles de lamas.

| Catégorie | Repère | # Shots | Métrique | Llama 3 8B | Llama 3.1 8B | Llama 3 70B | Llama 3.1 70B | Llama 3.1 405B |

|---|---|---|---|---|---|---|---|---|

| Général | MMLU | 5 | macro_avg/acc_char | 66.7 | 66.7 | 79.5 | 79.3 | 85.2 |

| MMLU-Pro (CoT) | 5 | macro_avg/acc_char | 36.2 | 37.1 | 55.0 | 53.8 | 61.6 | |

| AGIEval Anglais | 3-5 | moyenne/acc_char | 47.1 | 47.8 | 63.0 | 64.6 | 71.6 | |

| CommonSenseQA | 7 | acc_char | 72.6 | 75.0 | 83.8 | 84.1 | 85.8 | |

| Winogrande | 5 | acc_char | – | 60.5 | – | 83.3 | 86.7 | |

| BIG-Bench Hard (CoT) | 3 | moyenne/em | 61.1 | 64.2 | 81.3 | 81.6 | 85.9 | |

| Défi ARC | 25 | acc_char | 79.4 | 79.7 | 93.1 | 92.9 | 96.1 | |

| Raisonnement des connaissances | TriviaQA-Wiki | 5 | ém | 78.5 | 77.6 | 89.7 | 89.8 | 91.8 |

| Compréhension de la lecture | SQuAD | 1 | ém | 76.4 | 77.0 | 85.6 | 81.8 | 89.3 |

| QuAC (F1) | 1 | f1 | 44.4 | 44.9 | 51.1 | 51.1 | 53.6 | |

| BoolQ | 0 | acc_char | 75.7 | 75.0 | 79.0 | 79.4 | 80.0 | |

| DROP (F1) | 3 | f1 | 58.4 | 59.5 | 79.7 | 79.6 | 84.8 |

Instruction Modèles accordés

Les Instruction Modèles accordés Le tableau fournit un aperçu ciblé de la manière dont les Llama 3.1 en particulier les modèles de Llama 3.1 405BLa section suivante présente des mesures de performance pour les tâches de suivi d'instructions, d'évaluation de code et de raisonnement. Cette section comprend des mesures de performance pour les tâches de suivi d'instructions, d'évaluation de code et de raisonnement, mettant en évidence l'amélioration de l'efficacité du système de gestion de l'information. Capacités en matière d'IA grâce au réglage de l'instruction. Il s'agit d'une ressource essentielle pour comprendre les spécifications du modèle qui conduisent les online Llama 3.1 405B ChatLa capacité du système à gérer des requêtes et des tâches complexes. Cette table est inestimable pour ceux qui développent des applications ou créent des guides de l'utilisateur qui s'appuient sur la Llama 3.1 les capacités avancées des modèles.

| Catégorie | Repère | # Shots | Métrique | Llama 3 8B Instruct | Llama 3.1 8B Instruct | Llama 3 70B Instruct | Llama 3.1 70B Instruct | Llama 3.1 405B Instruct |

|---|---|---|---|---|---|---|---|---|

| Général | MMLU | 5 | macro_avg/acc | 68.5 | 69.4 | 82.0 | 83.6 | 87.3 |

| MMLU (CoT) | 0 | macro_avg/acc | 65.3 | 73.0 | 80.9 | 86.0 | 88.6 | |

| MMLU-Pro (CoT) | 5 | micro_avg/acc_char | 45.5 | 48.3 | 63.4 | 66.4 | 73.3 | |

| IFEval | – | – | 76.8 | 80.4 | 82.9 | 87.5 | 88.6 | |

| Raisonnement | ARC-C | 0 | acc | 82.4 | 83.4 | 94.4 | 94.8 | 96.9 |

| GPQA | 0 | ém | 34.6 | 30.4 | 39.5 | 41.7 | 50.7 | |

| Code | HumanEval | 0 | pass@1 | 60.4 | 72.6 | 81.7 | 80.5 | 89.0 |

| MBPP ++ version de base | 0 | pass@1 | 70.6 | 72.8 | 82.5 | 86.0 | 88.6 | |

| Multipl-E HumanEval | 0 | pass@1 | – | 50.8 | – | 65.5 | 75.2 | |

| Multipl-E MBPP | 0 | pass@1 | – | 52.4 | – | 62.0 | 65.7 | |

| Mathématiques | GSM-8K (CoT) | 8 | em_maj1@1 | 80.6 | 84.5 | 93.0 | 95.1 | 96.8 |

| MATH (CoT) | 0 | final_em | 29.1 | 51.9 | 51.0 | 68.0 | 73.8 | |

| Utilisation des outils | API-Bank | 0 | acc | 48.3 | 82.6 | 85.1 | 90.0 | 92.0 |

| BFCL | 0 | acc | 60.3 | 76.1 | 83.0 | 84.8 | 88.5 | |

| Gorilla Benchmark API Bench | 0 | acc | 1.7 | 8.2 | 14.7 | 29.7 | 35.3 | |

| Nexus (0 coup) | 0 | macro_avg/acc | 18.1 | 38.5 | 47.8 | 56.7 | 58.7 | |

| Multilingue | MGSM multilingue (CoT) | 0 | ém | – | 68.9 | – | 86.9 | 91.6 |

Critères de référence multilingues

Les Critères de référence multilingues Le tableau présente les performances des Llama 3.1 dans différentes langues, notamment le portugais, l'espagnol, l'italien, l'allemand, le français, l'hindi et le thaï. Cette section illustre la capacité des modèles à gérer des entrées multilingues et fournit des mesures de performance spécifiques à chaque langue. Pour les personnes intéressées par le déploiement du online Llama 3.1 405B Chat dans divers contextes linguistiques, ce tableau met en évidence les Capacités en matière d'IA et spécifications techniques qui rendent ces modèles polyvalents dans différentes langues. Il s'agit d'une ressource essentielle pour comprendre dans quelle mesure les Modèles de lamas se produire à l'échelle mondiale scénarios d'utilisation et d'élaborer des guides de l'utilisateur.

| Catégorie | Repère | Langue | Llama 3.1 8B | Llama 3.1 70B | Llama 3.1 405B |

|---|---|---|---|---|---|

| Général | MMLU (5 photos, macro_avg/acc) | Portugais | 62.12 | 80.13 | 84.95 |

| Espagnol | 62.45 | 80.05 | 85.08 | ||

| Italien | 61.63 | 80.4 | 85.04 | ||

| Allemand | 60.59 | 79.27 | 84.36 | ||

| Français | 62.34 | 79.82 | 84.66 | ||

| Hindi | 50.88 | 74.52 | 80.31 | ||

| Thaïlande | 50.32 | 72.95 | 78.21 |

Évaluations de modèles avec indices de référence