Llama 3.1 405B Chat con Búsqueda Web

Pruebe Reflection 70B Chat - Basado en Llama 3.1

Apoyo lingüístico

Inglés: ¡Mi lengua materna!

Español¡Hola! ¡Yo también converso en español!

Francés: ¡Oui, je parle Français, matey!

Alemán: ¡Aye, ich spreche Deutsch, too!

Italiano: ¡Ciao! ¡Estoy hablando en italiano, amigo!

Portugués: ¡Olá! ¡Yo también hablo portugués!

Holandés: ¡Hola! ¡Estoy hablando en holandés, colega!

Ruso: ¡Привет! ¡Yo también hablo Русский!

Chino(Simplificado) y (Tradicional) - ¡Sí, yo también hablo mandarín!

Japonés: ¡Konnichiwa! ¡Yo también estoy conversando!

Coreano¡Yo también hablo Hangul!

Árabe: ¡مرحبا! ¡Yo también converso en العربية!

Hebreo¡שלום! ¡Yo también hablo עברית!

* Dependiendo de su velocidad de Internet, la carga del modelo en línea puede tardar unos segundos.

Online Llama 3.1 Chat | Modo Instrucción

Preguntas frecuentes sobre Llama 3.1

1. ¿Qué es Meta Llama 3.1 405B?

Meta Llama 3.1 es el último modelo lingüístico de Meta, que cuenta con 405.000 millones de parámetros. Ofrece funciones avanzadas de procesamiento del lenguaje natural, como generación de textos, traducción de idiomas y sistemas de conversación.

La forma más sencilla de utilizar Llama 3.1 es Llama AI Online

2. ¿Cómo puedo acceder a Meta Llama 3.1?

Puedes acceder a Meta Llama 3.1 y sus recursos a través de la web oficial llama.meta.com y explore la ficha completa del modelo y las instrucciones de uso en Repositorio GitHub de Meta.

3. ¿Qué diferencia a Meta Llama 3.1 de las versiones anteriores?

Meta Llama 3.1 cuenta con 405.000 millones de parámetros, lo que la convierte en uno de los modelos lingüísticos más potentes del mercado. Ofrece mayor precisión y eficacia en la comprensión y generación de lenguaje natural.

4. ¿Cuáles son las principales aplicaciones de Meta Llama 3.1 405B?

Meta Llama 3.1 está diseñada para diversas aplicaciones, como la generación de textos, la traducción de idiomas y los sistemas de conversación, lo que la convierte en una herramienta versátil para desarrolladores e investigadores.

5. ¿Cómo mejora Meta Llama 3.1 las tareas de procesamiento del lenguaje natural?

Con sus amplios parámetros y su arquitectura avanzada, Meta Llama 3.1 proporciona resultados más precisos y contextualmente relevantes, mejorando el rendimiento de las tareas de procesamiento del lenguaje natural.

6. ¿Dónde puedo encontrar la ficha de modelo de Meta Llama 3.1?

La ficha de modelo de Meta Llama 3.1 se encuentra en el repositorio oficial de Meta en GitHub. Incluye información detallada sobre las capacidades del modelo, directrices de uso y especificaciones técnicas.

7. ¿Está Meta Llama 3.1 disponible para su uso en código abierto?

Sí, Meta Llama 3.1 está disponible para su uso como código abierto. Meta proporciona amplios recursos y documentación para ayudar a los desarrolladores a integrar y utilizar el modelo de forma eficaz.

8. ¿Cómo puedo utilizar Meta Llama 3.1 para aplicaciones de chat en línea?

Meta Llama 3.1 puede integrarse en aplicaciones de chat en línea para mejorar las capacidades conversacionales. Puede aprovechar su comprensión avanzada del lenguaje natural para crear chatbots más interactivos y receptivos.

9. ¿Qué recursos existen para aprender a utilizar Meta Llama 3.1?

Meta ofrece amplios recursos, incluida una ficha detallada del modelo, instrucciones de uso y ejemplos en su Repositorio GitHub. Además, la mejor herramienta para explorar Meta Llama 3.1 es a través de https://llamaai.online/.

10. ¿Se puede utilizar Meta Llama 3.1 para tareas de traducción de idiomas?

Sí, Meta Llama 3.1 es muy eficaz en tareas de traducción de idiomas. Sus avanzadas capacidades de procesamiento del lenguaje natural garantizan traducciones precisas y adecuadas al contexto en diferentes idiomas.

Chat Online Llama 3.1 405B: Guía en profundidad

Meta Llama 3.1 es el último modelo lingüístico de Meta, que cuenta con 405.000 millones de parámetros. Ofrece funciones avanzadas de procesamiento del lenguaje natural, como generación de textos, traducción de idiomas y sistemas de conversación.

Índice

- ¿Qué es Llama 3.1 405B?

- Importancia de Llama 3.1 405B para Meta AI

- Ventajas de utilizar el chat en línea Llama 3.1 405B

- Escenarios adecuados para utilizar el chat en línea Llama 3.1 405B

- Quién puede utilizar el chat Online Llama 3.1 405B

- Alternativas a Llama 3.1 405B Models y Pros & Contras

¿Qué es Llama 3.1 405B?

Llama 3.1 405B es la última iteración de la serie Llama de Meta AI, con importantes avances en el procesamiento y la comprensión del lenguaje natural. Este modelo cuenta con 405.000 millones de parámetros, lo que lo convierte en uno de los modelos de IA más potentes hasta la fecha. Sus principales aplicaciones incluyen la traducción de idiomas, la IA conversacional y el análisis avanzado de textos.

Importancia de Llama 3.1 405B para Meta AI

El modelo Llama 3.1 405B es la piedra angular de la estrategia de Meta AI para ampliar los límites de las capacidades de IA. Su amplio conjunto de parámetros permite un procesamiento del lenguaje más matizado y preciso, lo que resulta crucial para desarrollar aplicaciones de IA de nueva generación. Este modelo es compatible con una amplia gama de tareas, desde simples chatbots hasta complejas herramientas de análisis de datos, lo que subraya el compromiso de Meta AI con la innovación.

Ventajas de utilizar el chat en línea Llama 3.1 405B

Rendimiento mejorado

El chat en línea Llama 3.1 405B ofrece un rendimiento inigualable en términos de precisión y velocidad de respuesta. Los usuarios se benefician de un interlocutor altamente receptivo e inteligente, capaz de comprender y generar textos de apariencia humana.

Accesibilidad

Al proporcionar una interfaz en línea, Meta AI garantiza que los usuarios puedan acceder a las potentes funciones de Llama 3.1 405B sin necesidad de grandes conocimientos técnicos o de hardware. Esto democratiza el acceso a las capacidades avanzadas de IA.

Versatilidad

La plataforma de chat en línea puede utilizarse en diversos sectores, como la atención al cliente, la educación y la creación de contenidos. Su capacidad para comprender y generar respuestas contextualmente relevantes la convierte en una valiosa herramienta tanto para profesionales como para aficionados.

Escenarios adecuados para utilizar el chat en línea Llama 3.1 405B

Atención al cliente

Las empresas pueden aprovechar el chat en línea Llama 3.1 405B para ofrecer una atención al cliente eficiente y eficaz, gestionando un gran volumen de consultas simultáneamente y proporcionando respuestas precisas.

Herramientas educativas

Educadores y estudiantes pueden utilizar esta IA con fines didácticos, como la práctica de idiomas, la recuperación de información y las sesiones de tutoría interactiva.

Creación de contenidos

Escritores y profesionales del marketing pueden utilizar la IA para generar ideas, redactar contenidos e incluso editar y mejorar textos existentes, agilizando el proceso de creación de contenidos.

Quién puede utilizar el chat Online Llama 3.1 405B

El chat en línea Llama 3.1 405B está diseñado para una amplia gama de usuarios, entre los que se incluyen:

- Empresas: Para mejorar la interacción con el cliente y los servicios de asistencia.

- Educadores y estudiantes: Como ayuda al aprendizaje y recurso informativo.

- Creadores de contenidos: Aumentar la productividad y la creatividad en la generación de contenidos.

- Investigadores: Para realizar análisis avanzados de textos y estudios relacionados con el lenguaje.

Alternativas a Llama 3.1 405B Models y Pros & Contras

| Modelo | Pros | Contras |

|---|---|---|

| GPT-4 | Datos de formación muy avanzados y exhaustivos | Requiere importantes recursos informáticos |

| BERT | Excelente para comprender el contexto de un texto | No tan fuerte en la generación de texto |

| T5 | Versátil y potente tanto en comprensión como en generación | Puede ser más lento debido a su complejidad |

| RoBERTa | Mayor solidez y rendimiento que BERT | Limitado a tareas específicas, menos versátil |

Especificaciones del modelo Llama 3.1

En Especificaciones del modelo Llama 3.1 ofrece un desglose detallado de las especificaciones técnicas clave de varios modelos Llama 3.1, incluidas las versiones 8B, 70B y 405B. En esta tabla se destacan aspectos cruciales como los datos de entrenamiento, el tamaño de los parámetros, las modalidades de entrada y salida, la longitud del contexto y el recuento de tokens, todos ellos fundamentales para comprender la eficacia de los modelos Llama. métricas de rendimiento y Capacidades de IA de estos modelos. Para los usuarios que buscan Modelos de llamas y sus aplicaciones en Desarrollo de la IAEsta visión general constituye una referencia esencial. Tanto si explora escenarios de uso o profundizar en los entresijos técnicos de online Llama 3.1 405B ChatEsta tabla proporciona los datos básicos necesarios para comprender la escala y el alcance de los avances de Meta AI en especificaciones del modelo.

| Modelo | Datos de formación | Parámetros | Modalidades de entrada | Modalidades de salida | Contexto Longitud | GQA | Recuento de fichas | Límite de conocimientos |

|---|---|---|---|---|---|---|---|---|

| 8B | Una nueva combinación de datos en línea a disposición del público. | 8B | Texto multilingüe | Texto y código multilingües | 128k | Sí | 15T+ | Diciembre de 2023 |

| 70B | Una nueva combinación de datos en línea a disposición del público. | 70B | Texto multilingüe | Texto y código multilingües | 128k | Sí | 15T+ | Diciembre de 2023 |

| 405B | Una nueva combinación de datos en línea a disposición del público. | 405B | Texto multilingüe | Texto y código multilingües | 128k | Sí | 15T+ | Diciembre de 2023 |

Impacto ambiental y uso de recursos de la llama 3.1 Modelos

En Impacto ambiental y uso de recursos de la llama 3.1 Modelos ofrece una visión completa de la tiempo de formación, consumo de energíay emisiones de gases de efecto invernadero asociados a diferentes modelos de Llama 3.1, incluidas las versiones 8B, 70B y 405B. Este análisis es crucial para comprender la huella medioambiental de Desarrollo de la IA procesos, en particular para los modelos con especificaciones técnicas y los recursos necesarios. Para quienes estén interesados en las implicaciones más amplias de la implantación de la Capacidades de IA como el online Llama 3.1 405B Chateste cuadro arroja luz sobre la métricas de rendimiento relacionados con la sostenibilidad. Los datos presentados no sólo subrayan las importantes necesidades de recursos de los Modelos de llamas pero también destaca la importancia de tener en cuenta los factores medioambientales en guías del usuario y prácticas de desarrollo.

| Modelo | Tiempo de formación (horas GPU) | Formación Consumo de energía (W) | Emisiones de gases de efecto invernadero en función de la ubicación (toneladas de CO2eq) | Emisiones de gases de efecto invernadero basadas en el mercado (toneladas de CO2eq) |

|---|---|---|---|---|

| Llama 3.1 8B | 1.46M | 700 | 420 | 0 |

| Llama 3.1 70B | 7.0M | 700 | 2,040 | 0 |

| Llama 3.1 405B | 30.84M | 700 | 8,930 | 0 |

| Total | 39.3M | 11,390 | 0 |

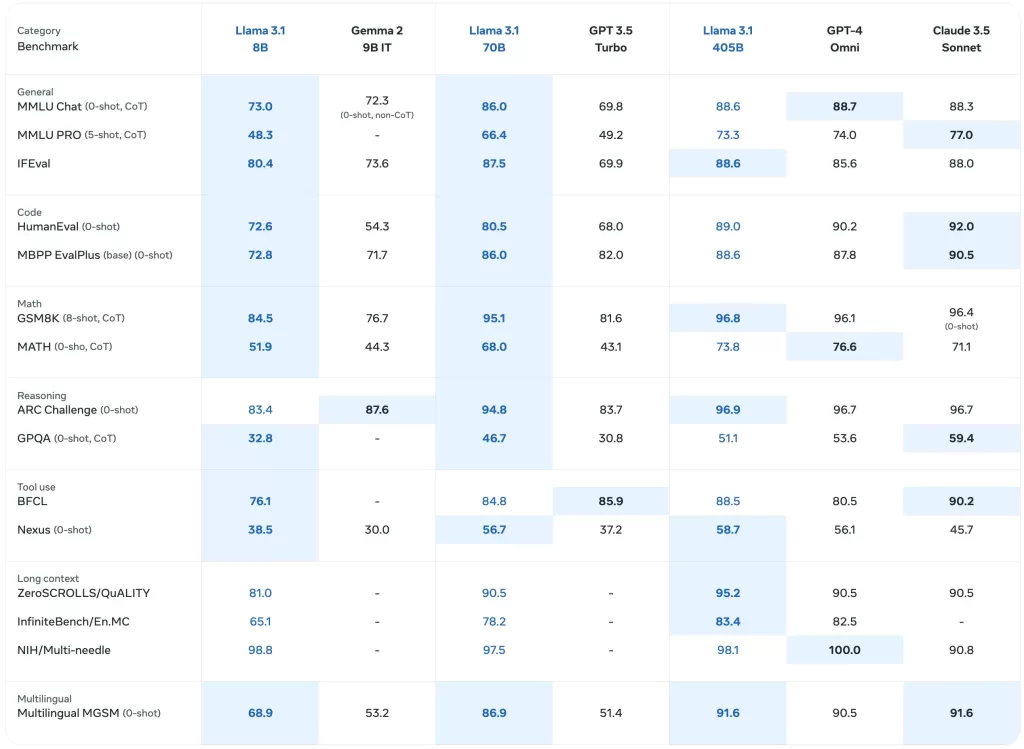

Rendimiento de referencia de los modelos Llama 3.1

En Rendimiento de referencia de los modelos Llama 3.1 ofrece una evaluación detallada de varios modelos de Llama, incluidos los últimos Llama 3.1 405Ben toda una gama de métricas de rendimiento. Este exhaustivo análisis incluye puntos de referencia para tareas generales, razonamiento de conocimientos, comprensión lectora, etc., y ofrece una perspectiva de la Capacidades de IA de estos modelos. Para los interesados en Desarrollo de la IA y las aplicaciones reales de Modelos de llamasEn este cuadro se destacan los especificaciones técnicas y eficacia de cada modelo. Constituye un valioso recurso para comprender el rendimiento comparativo de los online Llama 3.1 405B Chat y sus predecesores en varios escenarios de uso.

Modelos de base preentrenados

En Modelos de base preentrenados cuadro presenta una visión comparativa de la Llama 3 y Llama 3.1 a través de varios parámetros y métricas. Esta sección incluye datos sobre el rendimiento general, el razonamiento basado en el conocimiento y la comprensión lectora, que reflejan el rendimiento de los modelos. especificaciones técnicas y Capacidades de IA. Con resultados detallados para cada modelo, incluidos los Llama 3.1 405BEsta tabla es esencial para evaluar el rendimiento inicial de estos modelos en diversos contextos. Para los usuarios que exploran online Llama 3.1 405B Chat y su eficacia, este cuadro ofrece valiosas perspectivas sobre los puntos de referencia fundamentales que sustentan estas Modelos de llamas.

| Categoría | Punto de referencia | Disparos # | Métrica | Llama 3 8B | Llama 3.1 8B | Llama 3 70B | Llama 3.1 70B | Llama 3.1 405B |

|---|---|---|---|---|---|---|---|---|

| General | MMLU | 5 | macro_avg/acc_char | 66.7 | 66.7 | 79.5 | 79.3 | 85.2 |

| MMLU-Pro (CoT) | 5 | macro_avg/acc_char | 36.2 | 37.1 | 55.0 | 53.8 | 61.6 | |

| AGIEval Inglés | 3-5 | media/acc_char | 47.1 | 47.8 | 63.0 | 64.6 | 71.6 | |

| CommonSenseQA | 7 | acc_char | 72.6 | 75.0 | 83.8 | 84.1 | 85.8 | |

| Winogrande | 5 | acc_char | – | 60.5 | – | 83.3 | 86.7 | |

| BIG-Bench Hard (CoT) | 3 | media/em | 61.1 | 64.2 | 81.3 | 81.6 | 85.9 | |

| Reto ARC | 25 | acc_char | 79.4 | 79.7 | 93.1 | 92.9 | 96.1 | |

| Razonamiento del conocimiento | TriviaQA-Wiki | 5 | em | 78.5 | 77.6 | 89.7 | 89.8 | 91.8 |

| Comprensión lectora | SQuAD | 1 | em | 76.4 | 77.0 | 85.6 | 81.8 | 89.3 |

| QuAC (F1) | 1 | f1 | 44.4 | 44.9 | 51.1 | 51.1 | 53.6 | |

| BoolQ | 0 | acc_char | 75.7 | 75.0 | 79.0 | 79.4 | 80.0 | |

| DROP (F1) | 3 | f1 | 58.4 | 59.5 | 79.7 | 79.6 | 84.8 |

Instrucción Modelos sintonizados

En Instrucción Modelos sintonizados ofrece una visión centrada en cómo Llama 3.1 modelos, en particular el Llama 3.1 405Bcuando se ajustan a tareas específicas. Esta sección incluye métricas de rendimiento para tareas de seguimiento de instrucciones, evaluación de código y razonamiento, destacando la mejora de Capacidades de IA mediante el ajuste de las instrucciones. Es un recurso fundamental para comprender la especificaciones del modelo que impulsan el online Llama 3.1 405B Chatpara manejar consultas y tareas complejas. Esta tabla tiene un valor incalculable para quienes desarrollan aplicaciones o crean guías del usuario que aprovechan la Llama 3.1 capacidades avanzadas de los modelos.

| Categoría | Punto de referencia | Disparos # | Métrica | Llama 3 8B Construir | Llama 3.1 8B Construir | Llama 3 70B Instruir | Llama 3.1 70B Construir | Llama 3.1 405B Construir |

|---|---|---|---|---|---|---|---|---|

| General | MMLU | 5 | macro_avg/acc | 68.5 | 69.4 | 82.0 | 83.6 | 87.3 |

| MMLU (CoT) | 0 | macro_avg/acc | 65.3 | 73.0 | 80.9 | 86.0 | 88.6 | |

| MMLU-Pro (CoT) | 5 | micro_avg/acc_char | 45.5 | 48.3 | 63.4 | 66.4 | 73.3 | |

| IFEval | – | – | 76.8 | 80.4 | 82.9 | 87.5 | 88.6 | |

| Razonamiento | ARC-C | 0 | acc | 82.4 | 83.4 | 94.4 | 94.8 | 96.9 |

| GPQA | 0 | em | 34.6 | 30.4 | 39.5 | 41.7 | 50.7 | |

| Código | HumanEval | 0 | pass@1 | 60.4 | 72.6 | 81.7 | 80.5 | 89.0 |

| MBPP ++ versión base | 0 | pass@1 | 70.6 | 72.8 | 82.5 | 86.0 | 88.6 | |

| Multipl-E HumanEval | 0 | pass@1 | – | 50.8 | – | 65.5 | 75.2 | |

| Multipl-E MBPP | 0 | pass@1 | – | 52.4 | – | 62.0 | 65.7 | |

| Matemáticas | GSM-8K (CoT) | 8 | em_maj1@1 | 80.6 | 84.5 | 93.0 | 95.1 | 96.8 |

| MATEMÁTICAS (CoT) | 0 | final_em | 29.1 | 51.9 | 51.0 | 68.0 | 73.8 | |

| Uso de herramientas | API-Banco | 0 | acc | 48.3 | 82.6 | 85.1 | 90.0 | 92.0 |

| BFCL | 0 | acc | 60.3 | 76.1 | 83.0 | 84.8 | 88.5 | |

| Gorilla Benchmark API Bench | 0 | acc | 1.7 | 8.2 | 14.7 | 29.7 | 35.3 | |

| Nexus (0 disparos) | 0 | macro_avg/acc | 18.1 | 38.5 | 47.8 | 56.7 | 58.7 | |

| Multilingüe | MGSM multilingüe (CoT) | 0 | em | – | 68.9 | – | 86.9 | 91.6 |

Puntos de referencia multilingües

En Puntos de referencia multilingües muestra el rendimiento de Llama 3.1 en varios idiomas: portugués, español, italiano, alemán, francés, hindi y tailandés. Esta sección ilustra la capacidad de los modelos para manejar entradas multilingües y proporciona métricas de rendimiento específicas para cada idioma. Los interesados en utilizar los modelos online Llama 3.1 405B Chat en diversos contextos lingüísticos, este cuadro pone de relieve la Capacidades de IA y especificaciones técnicas que hacen que estos modelos sean versátiles en distintas lenguas. Se trata de un recurso clave para comprender en qué medida la Modelos de llamas actuar en global escenarios de uso y para elaborar guías del usuario.

| Categoría | Punto de referencia | Idioma | Llama 3.1 8B | Llama 3.1 70B | Llama 3.1 405B |

|---|---|---|---|---|---|

| General | MMLU (5 disparos, macro_avg/acc) | Portugués | 62.12 | 80.13 | 84.95 |

| Español | 62.45 | 80.05 | 85.08 | ||

| Italiano | 61.63 | 80.4 | 85.04 | ||

| Alemán | 60.59 | 79.27 | 84.36 | ||

| Francés | 62.34 | 79.82 | 84.66 | ||

| Hindi | 50.88 | 74.52 | 80.31 | ||

| Tailandés | 50.32 | 72.95 | 78.21 |

Evaluaciones de modelos con parámetros de referencia