Llama 3.1 405B Chat mit Websuche

Versuchen Sie Reflection 70B Chat - Basierend auf Llama 3.1

Unterstützende Sprache

Englisch: Meine Muttersprache!

Spanisch: ¡Hola! Ich spreche auch Spanisch!

Französisch: Oui, je parle Français, matey!

Deutsch: Aye, ich spreche auch Deutsch!

Italienisch: Ciao! Ich unterhalte mich auf Italiano, Kumpel!

Portugiesisch: Olá! Ich spreche auch Português!

Niederländisch: Hallo! Ich unterhalte mich auf Niederländisch, Kumpel!

Russisch: Привет! Ich spreche auch Русский!

Chinesisch(Vereinfacht) und (Traditionell) - Aye, ich spreche auch Mandarin!

Japanisch: Konnichiwa! Ich werde auch mitreden!

Koreanisch: - Ja, ich spreche auch Hangul!

Arabisch: مرحبا! Ich unterhalte mich auch in العربية!

Hebräisch: שלום! Ich spreche auch עברית!

* Je nach Ihrer Internetgeschwindigkeit kann das Laden des Modells einige Sekunden dauern.

Online Llama 3.1 Chat | Anleitungsmodus

Häufig gestellte Fragen zu Llama 3.1

1. Was ist Meta Llama 3.1 405B?

Meta Llama 3.1 ist das neueste Sprachmodell von Meta, das 405 Milliarden Parameter umfasst. Es bietet fortschrittliche Funktionen für die Verarbeitung natürlicher Sprache, einschließlich Textgenerierung, Sprachübersetzung und Konversationssysteme.

Der einfachste Weg, Llama 3.1 zu benutzen, ist Llama AI Online

2. Wie kann ich auf Meta Llama 3.1 zugreifen?

Sie können auf Meta Llama 3.1 und seine Ressourcen über die offizielle Website zugreifen lama.meta.com und erkunden Sie die umfassende Modellkarte und Gebrauchsanweisung auf Metas GitHub-Repository.

3. Wodurch unterscheidet sich Meta Llama 3.1 von früheren Versionen?

Meta Llama 3.1 verfügt über 405 Milliarden Parameter und ist damit eines der leistungsfähigsten Sprachmodelle auf dem Markt. Es bietet verbesserte Genauigkeit und Effizienz beim Verstehen und Generieren natürlicher Sprache.

4. Was sind die Hauptanwendungen von Meta Llama 3.1 405B?

Meta Llama 3.1 ist für verschiedene Anwendungen konzipiert, darunter Texterzeugung, Sprachübersetzung und Konversationssysteme, was es zu einem vielseitigen Werkzeug für Entwickler und Forscher macht.

5. Wie verbessert Meta Llama 3.1 Aufgaben zur Verarbeitung natürlicher Sprache?

Mit seinen umfangreichen Parametern und seiner fortschrittlichen Architektur liefert Meta Llama 3.1 genauere und kontextuell relevante Ergebnisse und steigert so die Leistung bei der Verarbeitung natürlicher Sprache.

6. Wo kann ich die Modellkarte für Meta Llama 3.1 finden?

Die Modellkarte für Meta Llama 3.1 ist auf dem offiziellen GitHub-Repository von Meta zu finden. Sie enthält detaillierte Informationen über die Fähigkeiten des Modells, Nutzungsrichtlinien und technische Spezifikationen.

7. Ist Meta Llama 3.1 als Open-Source-Version verfügbar?

Ja, Meta Llama 3.1 ist für die Open-Source-Nutzung verfügbar. Meta stellt umfassende Ressourcen und Dokumentationen zur Verfügung, die Entwicklern helfen, das Modell effektiv zu integrieren und zu nutzen.

8. Wie kann ich Meta Llama 3.1 für Online-Chat-Anwendungen verwenden?

Meta Llama 3.1 kann in Online-Chat-Anwendungen integriert werden, um die Konversationsfähigkeiten zu verbessern. Sie können sein fortschrittliches natürliches Sprachverständnis nutzen, um interaktivere und reaktionsschnellere Chatbots zu erstellen.

9. Welche Ressourcen stehen zur Verfügung, um zu lernen, wie man Meta Llama 3.1 benutzt?

Meta bietet umfangreiche Ressourcen, einschließlich einer detaillierten Modellkarte, Gebrauchsanweisungen und Beispiele auf ihrer GitHub-Repository. Darüber hinaus ist das beste Werkzeug, um Meta Llama 3.1 zu erkunden, durch https://llamaai.online/.

10. Kann Meta Llama 3.1 für Sprachübersetzungsaufgaben verwendet werden?

Ja, Meta Llama 3.1 ist hocheffektiv für Sprachübersetzungsaufgaben. Seine fortschrittlichen Funktionen zur Verarbeitung natürlicher Sprache gewährleisten genaue und kontextgerechte Übersetzungen in verschiedenen Sprachen.

Online Llama 3.1 405B Chat: Ein detaillierter Leitfaden

Meta Llama 3.1 ist das neueste Sprachmodell von Meta, das 405 Milliarden Parameter umfasst. Es bietet fortschrittliche Funktionen für die Verarbeitung natürlicher Sprache, einschließlich Textgenerierung, Sprachübersetzung und Konversationssysteme.

Inhaltsübersicht

- Was ist Llama 3.1 405B?

- Die Bedeutung von Llama 3.1 405B für Meta AI

- Vorteile der Verwendung von Online Llama 3.1 405B Chat

- Geeignete Szenarien für die Verwendung des Online Llama 3.1 405B Chat

- Wer kann Online Llama 3.1 405B Chat benutzen

- Alternativen zu Llama 3.1 405B Modellen und Vor- und Nachteile

Was ist Llama 3.1 405B?

Llama 3.1 405B ist die neueste Iteration der Llama-Serie von Meta AI und bietet bedeutende Fortschritte bei der Verarbeitung und dem Verständnis natürlicher Sprache. Dieses Modell verfügt über 405 Milliarden Parameter und ist damit eines der bisher leistungsfähigsten KI-Modelle. Zu seinen Hauptanwendungen gehören Sprachübersetzung, Konversations-KI und erweiterte Textanalyse.

Die Bedeutung von Llama 3.1 405B für Meta AI

Das Modell Llama 3.1 405B ist ein Eckpfeiler der Strategie von Meta AI, die Grenzen der KI-Fähigkeiten zu erweitern. Sein umfangreicher Parametersatz ermöglicht eine nuanciertere und genauere Sprachverarbeitung, die für die Entwicklung von KI-Anwendungen der nächsten Generation entscheidend ist. Dieses Modell unterstützt eine breite Palette von Aufgaben, von einfachen Chatbots bis hin zu komplexen Datenanalysetools, und unterstreicht das Engagement von Meta AI für Innovation.

Vorteile der Verwendung von Online Llama 3.1 405B Chat

Verbesserte Leistung

Der Online-Chat Llama 3.1 405B bietet unübertroffene Leistung in Bezug auf Antwortgenauigkeit und Geschwindigkeit. Die Nutzer profitieren von einem äußerst reaktionsschnellen und intelligenten Gesprächspartner, der in der Lage ist, menschenähnlichen Text zu verstehen und zu erzeugen.

Erreichbarkeit

Durch die Bereitstellung einer Online-Schnittstelle stellt Meta AI sicher, dass die Nutzer auf die leistungsstarken Funktionen von Llama 3.1 405B zugreifen können, ohne dass sie umfangreiche Hardware oder technisches Know-how benötigen. Dadurch wird der Zugang zu fortschrittlichen KI-Funktionen demokratisiert.

Vielseitigkeit

Die Online-Chat-Plattform kann in verschiedenen Branchen eingesetzt werden, z. B. im Kundendienst, im Bildungswesen und bei der Erstellung von Inhalten. Ihre Fähigkeit, kontextbezogene Antworten zu verstehen und zu generieren, macht sie zu einem wertvollen Werkzeug für Profis und Enthusiasten gleichermaßen.

Geeignete Szenarien für die Verwendung des Online Llama 3.1 405B Chat

Kundenbetreuung

Unternehmen können den Online-Chat von Llama 3.1 405B für einen effizienten und effektiven Kundensupport nutzen, indem sie eine große Anzahl von Anfragen gleichzeitig bearbeiten und dabei präzise Antworten geben.

Pädagogische Werkzeuge

Pädagogen und Schüler können diese KI zu Lernzwecken einsetzen, z. B. zum Üben von Sprachen, zum Abrufen von Informationen und für interaktive Nachhilfestunden.

Erstellung von Inhalten

Autoren und Vermarkter können die KI nutzen, um Ideen zu generieren, Inhalte zu entwerfen und sogar bestehende Texte zu bearbeiten und zu verbessern, um den Prozess der Inhaltserstellung zu rationalisieren.

Wer kann Online Llama 3.1 405B Chat benutzen

Der Online-Chat von Llama 3.1 405B ist für ein breites Spektrum von Nutzern konzipiert, darunter:

- Unternehmen: Verbesserung der Interaktion mit den Kunden und der Unterstützungsdienste.

- Pädagogen und Studenten: Als Lernhilfe und Informationsquelle.

- Ersteller von Inhalten: Steigerung der Produktivität und Kreativität bei der Erstellung von Inhalten.

- Forscher: Zur Durchführung fortgeschrittener Textanalysen und sprachbezogener Studien.

Alternativen zu Llama 3.1 405B Modellen und Vor- und Nachteile

| Modell | Profis | Nachteile |

|---|---|---|

| GPT-4 | Hochentwickelte, umfangreiche Schulungsdaten | Erfordert erhebliche Rechenressourcen |

| BERT | Hervorragend geeignet, um den Kontext eines Textes zu verstehen | Nicht so stark bei der Texterstellung |

| T5 | Vielseitig und leistungsstark, sowohl beim Verstehen als auch beim Erzeugen | Kann aufgrund seiner Komplexität langsamer sein |

| RoBERTa | Verbesserte Robustheit und Leistung gegenüber BERT | Begrenzt auf bestimmte Aufgaben, weniger vielseitig |

Llama 3.1 Modell Spezifikationen Übersicht

Die Llama 3.1 Modell Spezifikationen Übersicht bietet eine detaillierte Aufschlüsselung der wichtigsten technischen Spezifikationen für verschiedene Llama 3.1-Modelle, einschließlich der Versionen 8B, 70B und 405B. Diese Tabelle hebt wichtige Aspekte wie Trainingsdaten, Parametergröße, Eingabe- und Ausgabemodalitäten, Kontextlänge und Tokenanzahl hervor, die alle für das Verständnis der Leistungskennzahlen und KI-Fähigkeiten dieser Modelle. Für Nutzer, die Einblicke in Lama-Modelle und ihre Anwendungen in KI-Entwicklungdient dieser Überblick als unverzichtbares Nachschlagewerk. Ob Sie nun erforschen Nutzungsszenarien oder sich mit den technischen Feinheiten von online Llama 3.1 405B ChatDiese Tabelle enthält die grundlegenden Daten, die erforderlich sind, um das Ausmaß und den Umfang der Fortschritte von Meta AI in den folgenden Bereichen zu erfassen Modellspezifikationen.

| Modell | Ausbildungsdaten | Params | Modalitäten der Eingabe | Modalitäten der Ausgabe | Kontext Länge | GQA | Anzahl der Token | Wissen Cutoff |

|---|---|---|---|---|---|---|---|---|

| 8B | Ein neuer Mix aus öffentlich zugänglichen Online-Daten. | 8B | Mehrsprachiger Text | Mehrsprachiger Text und Code | 128k | Ja | 15T+ | Dezember 2023 |

| 70B | Ein neuer Mix aus öffentlich zugänglichen Online-Daten. | 70B | Mehrsprachiger Text | Mehrsprachiger Text und Code | 128k | Ja | 15T+ | Dezember 2023 |

| 405B | Ein neuer Mix aus öffentlich zugänglichen Online-Daten. | 405B | Mehrsprachiger Text | Mehrsprachiger Text und Code | 128k | Ja | 15T+ | Dezember 2023 |

Umweltauswirkungen und Ressourcenverbrauch von Lama 3.1 Modelle

Die Umweltauswirkungen und Ressourcenverbrauch von Lama 3.1 Modelle Tabelle bietet einen umfassenden Überblick über die Ausbildungszeit, Stromverbrauchund Treibhausgasemissionen in Verbindung mit verschiedenen Llama 3.1-Modellen, darunter die Versionen 8B, 70B und 405B. Diese Analyse ist entscheidend für das Verständnis des ökologischen Fußabdrucks von KI-Entwicklung Prozesse, insbesondere für Modelle mit umfangreichen technische Daten und Ressourcenanforderungen. Für diejenigen, die sich für die umfassenderen Auswirkungen des Einsatzes fortgeschrittener KI-Fähigkeiten wie die online Llama 3.1 405B ChatDiese Tabelle gibt Aufschluss über die Leistungskennzahlen im Zusammenhang mit der Nachhaltigkeit. Die vorgelegten Daten unterstreichen nicht nur den beträchtlichen Ressourcenbedarf modernster Lama-Modelle sondern unterstreicht auch die Bedeutung der Berücksichtigung von Umweltfaktoren bei Benutzerhandbücher und Entwicklungspraktiken.

| Modell | Ausbildungszeit (GPU-Stunden) | Training Leistungsaufnahme (W) | Standortbezogene Treibhausgasemissionen (Tonnen CO2eq) | Marktbedingte Treibhausgasemissionen (Tonnen CO2eq) |

|---|---|---|---|---|

| Lama 3.1 8B | 1.46M | 700 | 420 | 0 |

| Llama 3.1 70B | 7.0M | 700 | 2,040 | 0 |

| Llama 3.1 405B | 30.84M | 700 | 8,930 | 0 |

| Insgesamt | 39.3M | 11,390 | 0 |

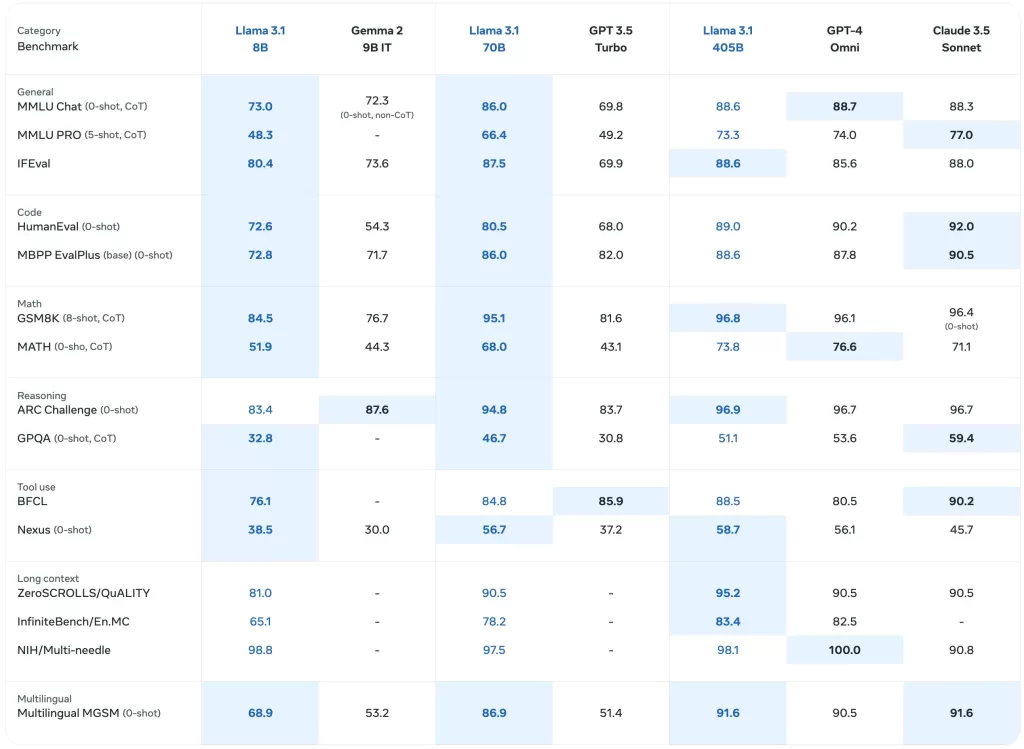

Benchmark-Leistung der Llama 3.1-Modelle

Die Benchmark-Leistung der Llama 3.1-Modelle Tabelle enthält eine detaillierte Bewertung der verschiedenen Llama-Modelle, einschließlich der neuesten Llama 3.1 405Büber eine Reihe von Leistungskennzahlen. Diese umfassende Analyse enthält Benchmarks für allgemeine Aufgaben, logisches Denken, Leseverständnis und mehr und bietet Einblicke in die KI-Fähigkeiten dieser Modelle. Für diejenigen, die sich für KI-Entwicklung und die realen Anwendungen von Lama-Modellehebt diese Tabelle die technische Daten und Wirksamkeit der einzelnen Modelle. Er dient als wertvolle Ressource für das Verständnis der vergleichenden Leistung der online Llama 3.1 405B Chat und seine Vorgänger in verschiedenen Nutzungsszenarien.

Basis vortrainierte Modelle

Die Basis vortrainierte Modelle Tabelle gibt einen vergleichenden Überblick über die Lama 3 und Lama 3.1 Modelle über mehrere Benchmarks und Metriken hinweg. Dieser Abschnitt enthält Daten zur allgemeinen Leistung, zum logischen Denken und zum Leseverständnis und spiegelt die Leistung der Modelle wider. technische Daten und KI-Fähigkeiten. Mit detaillierten Ergebnissen für jedes Modell, einschließlich der Llama 3.1 405BDiese Tabelle ist wichtig, um die anfängliche Leistung dieser Modelle in einer Vielzahl von Kontexten zu bewerten. Für Benutzer, die online Llama 3.1 405B Chat und ihrer Wirksamkeit bietet diese Tabelle wertvolle Einblicke in die grundlegenden Benchmarks, die diesen Maßnahmen zugrunde liegen Lama-Modelle.

| Kategorie | Benchmark | #-Aufnahmen | Metrisch | Lama 3 8B | Lama 3.1 8B | Llama 3 70B | Llama 3.1 70B | Llama 3.1 405B |

|---|---|---|---|---|---|---|---|---|

| Allgemein | MMLU | 5 | macro_avg/acc_char | 66.7 | 66.7 | 79.5 | 79.3 | 85.2 |

| MMLU-Pro (CoT) | 5 | macro_avg/acc_char | 36.2 | 37.1 | 55.0 | 53.8 | 61.6 | |

| AGIEval Englisch | 3-5 | Durchschnitt/acc_char | 47.1 | 47.8 | 63.0 | 64.6 | 71.6 | |

| CommonSenseQA | 7 | acc_char | 72.6 | 75.0 | 83.8 | 84.1 | 85.8 | |

| Winogrande | 5 | acc_char | – | 60.5 | – | 83.3 | 86.7 | |

| BIG-Bench Hard (CoT) | 3 | Durchschnitt/em | 61.1 | 64.2 | 81.3 | 81.6 | 85.9 | |

| ARC-Challenge | 25 | acc_char | 79.4 | 79.7 | 93.1 | 92.9 | 96.1 | |

| Wissen Reasoning | TriviaQA-Wiki | 5 | em | 78.5 | 77.6 | 89.7 | 89.8 | 91.8 |

| Leseverstehen | SQuAD | 1 | em | 76.4 | 77.0 | 85.6 | 81.8 | 89.3 |

| QuAC (F1) | 1 | f1 | 44.4 | 44.9 | 51.1 | 51.1 | 53.6 | |

| BoolQ | 0 | acc_char | 75.7 | 75.0 | 79.0 | 79.4 | 80.0 | |

| DROP (F1) | 3 | f1 | 58.4 | 59.5 | 79.7 | 79.6 | 84.8 |

Anweisung Gestimmte Modelle

Die Anweisung Gestimmte Modelle Tabelle bietet einen gezielten Blick darauf, wie Lama 3.1 Modelle, insbesondere die Llama 3.1 405Bbei der Feinabstimmung für bestimmte Aufgaben. Dieser Abschnitt enthält Leistungsmetriken für Aufgaben zur Befolgung von Anweisungen, Code-Evaluierung und schlussfolgerndes Denken und hebt die verbesserten KI-Fähigkeiten durch die Abstimmung von Anweisungen erreicht werden. Sie ist eine wichtige Ressource für das Verständnis der Modellspezifikationen die die online Llama 3.1 405B Chatdie Fähigkeit, komplexe Abfragen und Aufgaben zu bewältigen. Diese Tabelle ist von unschätzbarem Wert für alle, die Anwendungen entwickeln oder Benutzerhandbücher die sich auf die Lama 3.1 fortgeschrittenen Fähigkeiten der Modelle.

| Kategorie | Benchmark | #-Aufnahmen | Metrisch | Llama 3 8B Anleitung | Llama 3.1 8B Anleitung | Llama 3 70B Anleitung | Llama 3.1 70B Instruct | Llama 3.1 405B Anleitung |

|---|---|---|---|---|---|---|---|---|

| Allgemein | MMLU | 5 | makro_avg/acc | 68.5 | 69.4 | 82.0 | 83.6 | 87.3 |

| MMLU (CoT) | 0 | makro_avg/acc | 65.3 | 73.0 | 80.9 | 86.0 | 88.6 | |

| MMLU-Pro (CoT) | 5 | micro_avg/acc_char | 45.5 | 48.3 | 63.4 | 66.4 | 73.3 | |

| IFEval | – | – | 76.8 | 80.4 | 82.9 | 87.5 | 88.6 | |

| Begründung | ARC-C | 0 | acc | 82.4 | 83.4 | 94.4 | 94.8 | 96.9 |

| GPQA | 0 | em | 34.6 | 30.4 | 39.5 | 41.7 | 50.7 | |

| Code | HumanEval | 0 | Pass@1 | 60.4 | 72.6 | 81.7 | 80.5 | 89.0 |

| MBPP ++ Basisversion | 0 | Pass@1 | 70.6 | 72.8 | 82.5 | 86.0 | 88.6 | |

| Multipl-E HumanEval | 0 | Pass@1 | – | 50.8 | – | 65.5 | 75.2 | |

| Multipl-E MBPP | 0 | Pass@1 | – | 52.4 | – | 62.0 | 65.7 | |

| Mathematik | GSM-8K (CoT) | 8 | em_maj1@1 | 80.6 | 84.5 | 93.0 | 95.1 | 96.8 |

| MATH (CoT) | 0 | final_em | 29.1 | 51.9 | 51.0 | 68.0 | 73.8 | |

| Einsatz der Werkzeuge | API-Bank | 0 | acc | 48.3 | 82.6 | 85.1 | 90.0 | 92.0 |

| BFCL | 0 | acc | 60.3 | 76.1 | 83.0 | 84.8 | 88.5 | |

| Gorilla Benchmark API Bench | 0 | acc | 1.7 | 8.2 | 14.7 | 29.7 | 35.3 | |

| Nexus (0-Schuss) | 0 | makro_avg/acc | 18.1 | 38.5 | 47.8 | 56.7 | 58.7 | |

| Mehrsprachig | Mehrsprachiger MGSM (CoT) | 0 | em | – | 68.9 | – | 86.9 | 91.6 |

Mehrsprachige Benchmarks

Die Mehrsprachige Benchmarks Die Tabelle zeigt die Leistung von Lama 3.1 Modelle in verschiedenen Sprachen, darunter Portugiesisch, Spanisch, Italienisch, Deutsch, Französisch, Hindi und Thai. Dieser Abschnitt veranschaulicht die Fähigkeit der Modelle, mehrsprachige Eingaben zu verarbeiten, und liefert für jede Sprache spezifische Leistungskennzahlen. Für diejenigen, die sich für den Einsatz der online Llama 3.1 405B Chat in verschiedenen sprachlichen Kontexten, hebt diese Tabelle die KI-Fähigkeiten und technische Daten die diese Modelle über verschiedene Sprachen hinweg vielseitig einsetzbar machen. Es ist eine wichtige Ressource, um zu verstehen, wie gut die Lama-Modelle global auftreten Nutzungsszenarien und für die Ausarbeitung wirksamer Benutzerhandbücher.

| Kategorie | Benchmark | Sprache | Lama 3.1 8B | Llama 3.1 70B | Llama 3.1 405B |

|---|---|---|---|---|---|

| Allgemein | MMLU (5 Aufnahmen, makro_avg/acc) | Portugiesisch | 62.12 | 80.13 | 84.95 |

| Spanisch | 62.45 | 80.05 | 85.08 | ||

| Italienisch | 61.63 | 80.4 | 85.04 | ||

| Deutsch | 60.59 | 79.27 | 84.36 | ||

| Französisch | 62.34 | 79.82 | 84.66 | ||

| Hindi | 50.88 | 74.52 | 80.31 | ||

| Thailändisch | 50.32 | 72.95 | 78.21 |

Modellbewertungen mit Benchmarks