Llama 3.1 405B Chat med websøgning

Forsøg Reflection 70B Chat - baseret på Llama 3.1

Sproglig støtte

Engelsk: Mit modersmål!

Spansk: ¡Hola! Jeg taler også spansk!

Fransk: Oui, je parle Français, matey!

Tysk: Ja, jeg taler også tysk!

Italiensk: Ciao! Jeg snakker på italiensk, makker!

Portugisisk: Olá! Jeg taler også portugisisk!

Hollandsk: Hallo! Jeg taler hollandsk, makker!

Russer: Привет! Jeg taler også Русский!

Kinesisk: (forenklet) og (traditionel) - Ja, jeg taler også mandarin!

Japansk: Konnichiwa! Jeg snakker også med!

Koreansk: - Ja, jeg taler også hangul!

Arabisk: مرحبا! Jeg taler også العربية!

Hebraisk: שלום! Jeg taler også עברית!

* Afhængigt af din internethastighed kan det tage et par sekunder at indlæse modellen online.

Online Llama 3.1 Chat | Instruktionstilstand

Ofte stillede spørgsmål til Llama 3.1

1. Hvad er Meta Llama 3.1 405B?

Meta Llama 3.1 er Metas seneste sprogmodel med 405 milliarder parametre. Den tilbyder avancerede muligheder inden for naturlig sprogbehandling, herunder tekstgenerering, sprogoversættelse og samtalesystemer.

Den nemmeste måde at bruge Llama 3.1 på er Llama AI Online

2. Hvordan får jeg adgang til Meta Llama 3.1?

Du kan få adgang til Meta Llama 3.1 og dens ressourcer via den officielle hjemmeside lama.meta.com og udforsk det omfattende modelkort og brugsanvisningen på Metas GitHub-arkiv.

3. Hvad gør Meta Llama 3.1 anderledes end tidligere versioner?

Meta Llama 3.1 har 405 milliarder parametre, hvilket gør den til en af de mest kraftfulde sprogmodeller, der findes. Den giver forbedret nøjagtighed og effektivitet i forståelsen og genereringen af naturligt sprog.

4. Hvad er de vigtigste anvendelser af Meta Llama 3.1 405B?

Meta Llama 3.1 er designet til forskellige anvendelser, herunder tekstgenerering, sprogoversættelse og samtalesystemer, hvilket gør det til et alsidigt værktøj for udviklere og forskere.

5. Hvordan forbedrer Meta Llama 3.1 opgaver med naturlig sprogbehandling?

Med sine omfattende parametre og avancerede arkitektur giver Meta Llama 3.1 mere præcise og kontekstuelt relevante resultater, hvilket forbedrer ydeevnen for naturlige sprogbehandlingsopgaver.

6. Hvor kan jeg finde modelkortet til Meta Llama 3.1?

Modelkortet til Meta Llama 3.1 kan findes på Metas officielle GitHub-repository. Det indeholder detaljerede oplysninger om modellens muligheder, retningslinjer for brug og tekniske specifikationer.

7. Er Meta Llama 3.1 tilgængelig til open source-brug?

Ja, Meta Llama 3.1 er tilgængelig til open source-brug. Meta stiller omfattende ressourcer og dokumentation til rådighed for at hjælpe udviklere med at integrere og bruge modellen effektivt.

8. Hvordan kan jeg bruge Meta Llama 3.1 til online chat-applikationer?

Meta Llama 3.1 kan integreres i online chat-applikationer for at forbedre samtaleevnerne. Du kan udnytte dens avancerede naturlige sprogforståelse til at skabe mere interaktive og responsive chatbots.

9. Hvilke ressourcer er tilgængelige for at lære at bruge Meta Llama 3.1?

Meta tilbyder omfattende ressourcer, herunder et detaljeret modelkort, brugsanvisninger og eksempler på deres GitHub-arkiv. Derudover er det bedste værktøj til at udforske Meta Llama 3.1 gennem https://llamaai.online/.

10. Kan Meta Llama 3.1 bruges til sproglige oversættelsesopgaver?

Ja, Meta Llama 3.1 er meget effektiv til sprogoversættelsesopgaver. Dens avancerede funktioner til behandling af naturligt sprog sikrer nøjagtige og kontekstuelt passende oversættelser på tværs af forskellige sprog.

Online Llama 3.1 405B Chat: En dybdegående guide

Meta Llama 3.1 er Metas seneste sprogmodel med 405 milliarder parametre. Den tilbyder avancerede muligheder inden for naturlig sprogbehandling, herunder tekstgenerering, sprogoversættelse og samtalesystemer.

Indholdsfortegnelse

- Hvad er Llama 3.1 405B?

- Betydningen af Llama 3.1 405B for Meta AI

- Fordele ved at bruge Online Llama 3.1 405B Chat

- Egnede scenarier for brug af Online Llama 3.1 405B Chat

- Hvem kan bruge Online Llama 3.1 405B Chat

- Alternativer til Llama 3.1 405B-modeller og fordele og ulemper

Hvad er Llama 3.1 405B?

Llama 3.1 405B er den seneste udgave af Meta AI's Llama-serie, der byder på betydelige fremskridt inden for behandling og forståelse af naturligt sprog. Denne model har 405 milliarder parametre, hvilket gør den til en af de mest kraftfulde AI-modeller til dato. Dens primære anvendelsesområder omfatter sprogoversættelse, samtale-AI og avanceret tekstanalyse.

Betydningen af Llama 3.1 405B for Meta AI

Llama 3.1 405B-modellen er en hjørnesten i Meta AI's strategi for at skubbe grænserne for AI-kapaciteter. Dens store parametersæt giver mulighed for mere nuanceret og præcis sprogbehandling, hvilket er afgørende for at udvikle næste generations AI-applikationer. Denne model understøtter en bred vifte af opgaver, fra enkle chatbots til komplekse dataanalyseværktøjer, hvilket understreger Meta AI's engagement i innovation.

Fordele ved at bruge Online Llama 3.1 405B Chat

Forbedret ydeevne

Den online Llama 3.1 405B-chat tilbyder uovertruffen ydeevne med hensyn til svarnøjagtighed og -hastighed. Brugerne nyder godt af en meget lydhør og intelligent samtalepartner, der er i stand til at forstå og generere menneskelignende tekst.

Tilgængelighed

Ved at levere en online-grænseflade sikrer Meta AI, at brugerne kan få adgang til de kraftfulde funktioner i Llama 3.1 405B uden behov for omfattende hardware eller teknisk ekspertise. Dette demokratiserer adgangen til avancerede AI-funktioner.

Alsidighed

Onlinechatplatformen kan bruges på tværs af forskellige brancher, herunder kundeservice, uddannelse og indholdsskabelse. Dens evne til at forstå og generere kontekstuelt relevante svar gør den til et værdifuldt værktøj for både professionelle og entusiaster.

Egnede scenarier for brug af Online Llama 3.1 405B Chat

Kundesupport

Virksomheder kan udnytte den online Llama 3.1 405B-chat til effektiv kundesupport og håndtere en stor mængde forespørgsler på samme tid, samtidig med at de giver præcise svar.

Pædagogiske værktøjer

Undervisere og studerende kan bruge denne AI til læringsformål, herunder sprogøvelser, informationssøgning og interaktive vejledningssessioner.

Skabelse af indhold

Skribenter og marketingfolk kan bruge AI til at generere ideer, udarbejde indhold og endda redigere og forbedre eksisterende tekster, hvilket strømliner processen med at skabe indhold.

Hvem kan bruge Online Llama 3.1 405B Chat

Den online Llama 3.1 405B-chat er designet til en bred vifte af brugere, herunder:

- Virksomheder: For at forbedre kundeinteraktion og supporttjenester.

- Undervisere og studerende: Som læringshjælp og informationsressource.

- Skabere af indhold: At øge produktiviteten og kreativiteten i indholdsgenereringen.

- Forskere: Til udførelse af avanceret tekstanalyse og sprogrelaterede studier.

Alternativer til Llama 3.1 405B-modeller og fordele og ulemper

| Model | Fordele | Ulemper |

|---|---|---|

| GPT-4 | Meget avancerede, omfattende træningsdata | Kræver betydelige beregningsressourcer |

| BERT | Fremragende til at forstå sammenhængen i en tekst | Ikke så stærk i tekstgenerering |

| T5 | Alsidig og kraftfuld i både forståelse og generering | Kan være langsommere på grund af sin kompleksitet |

| RoBERTa | Forbedret robusthed og ydeevne i forhold til BERT | Begrænset til specifikke opgaver, mindre alsidig |

Oversigt over specifikationer for Llama 3.1-modellen

Den Oversigt over specifikationer for Llama 3.1-modellen giver en detaljeret oversigt over de vigtigste tekniske specifikationer for forskellige Llama 3.1-modeller, herunder 8B-, 70B- og 405B-versionerne. Denne tabel fremhæver vigtige aspekter som træningsdata, parameterstørrelse, input- og outputmodaliteter, kontekstlængde og tokenantal, som alle er afgørende for at forstå præstationsmålinger og AI-muligheder af disse modeller. For brugere, der søger indsigt i Lama-modeller og deres anvendelse i AI-udviklingfungerer denne oversigt som en vigtig reference. Uanset om du udforsker Brugsscenarier eller dykke ned i de tekniske finurligheder af online Llama 3.1 405B Chatgiver denne tabel de grundlæggende data, der er nødvendige for at forstå omfanget og rækkevidden af Meta AI's fremskridt inden for model specifikationer.

| Model | Træningsdata | Parametre | Input-modaliteter | Output-modaliteter | Kontekst Længde | GQA | Antal tokens | Cutoff for viden |

|---|---|---|---|---|---|---|---|---|

| 8B | En ny blanding af offentligt tilgængelige onlinedata. | 8B | Flersproget tekst | Flersproget tekst og kode | 128k | Ja | 15T+ | December 2023 |

| 70B | En ny blanding af offentligt tilgængelige onlinedata. | 70B | Flersproget tekst | Flersproget tekst og kode | 128k | Ja | 15T+ | December 2023 |

| 405B | En ny blanding af offentligt tilgængelige onlinedata. | 405B | Flersproget tekst | Flersproget tekst og kode | 128k | Ja | 15T+ | December 2023 |

Lamaernes miljøpåvirkning og ressourceforbrug 3.1 Modeller

Den Lamaernes miljøpåvirkning og ressourceforbrug 3.1 Modeller tabel giver et omfattende kig på træningstid, Strømforbrugog Udledning af drivhusgasser forbundet med forskellige Llama 3.1-modeller, herunder 8B-, 70B- og 405B-versionerne. Denne analyse er afgørende for at forstå det miljømæssige fodaftryk af AI-udvikling processer, især for modeller med omfattende Tekniske specifikationer og ressourcekrav. For dem, der er interesseret i de bredere konsekvenser af at anvende avancerede AI-muligheder ligesom online Llama 3.1 405B Chatkaster denne tabel lys over præstationsmålinger relateret til bæredygtighed. De præsenterede data understreger ikke kun de betydelige ressourcebehov for banebrydende Lama-modeller men understreger også vigtigheden af at tage hensyn til miljøfaktorer i Brugervejledninger og udviklingspraksis.

| Model | Træningstid (GPU-timer) | Strømforbrug til træning (W) | Stedsbaseret udledning af drivhusgasser (tons CO2eq) | Markedsbaseret udledning af drivhusgasser (tons CO2eq) |

|---|---|---|---|---|

| Llama 3.1 8B | 1.46M | 700 | 420 | 0 |

| Llama 3.1 70B | 7.0M | 700 | 2,040 | 0 |

| Llama 3.1 405B | 30.84M | 700 | 8,930 | 0 |

| I alt | 39.3M | 11,390 | 0 |

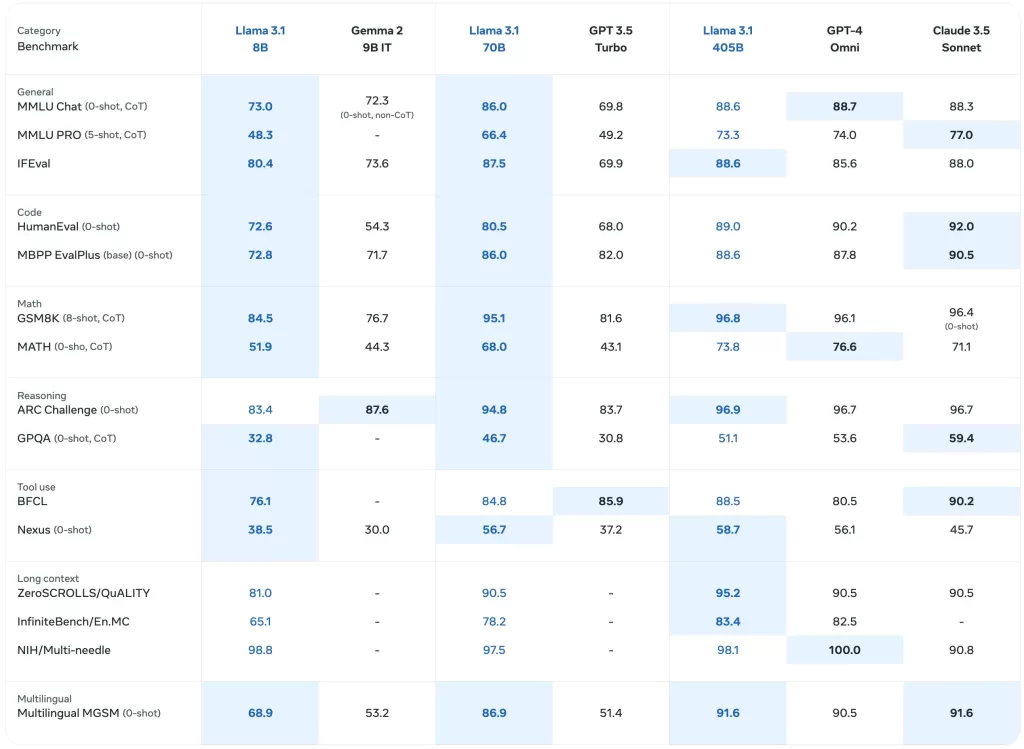

Benchmark-ydelse af Llama 3.1-modeller

Den Benchmark-ydelse af Llama 3.1-modeller tabel giver en detaljeret evaluering af forskellige Llama-modeller, herunder den seneste Llama 3.1 405Bpå tværs af en række præstationsmålinger. Denne omfattende analyse omfatter benchmarks for generelle opgaver, vidensbaseret ræsonnement, læseforståelse og meget mere, hvilket giver indsigt i... AI-muligheder af disse modeller. For dem, der er interesserede i AI-udvikling og den virkelige verdens anvendelser af Lama-modellerfremhæver denne tabel de Tekniske specifikationer og effektivitet af hver model. Den fungerer som en værdifuld ressource til at forstå de sammenlignelige resultater af online Llama 3.1 405B Chat og dens forgængere i forskellige Brugsscenarier.

Foruddannede basismodeller

Den Foruddannede basismodeller Tabellen viser en sammenlignende oversigt over Lama 3 og Llama 3.1 modeller på tværs af flere benchmarks og målinger. Dette afsnit indeholder data om generel præstation, vidensræsonnement og læseforståelse, hvilket afspejler modellernes Tekniske specifikationer og AI-muligheder. Med detaljerede resultater for hver model, herunder Llama 3.1 405Ber denne tabel vigtig for at vurdere disse modellers indledende ydeevne i en række forskellige sammenhænge. For brugere, der udforsker online Llama 3.1 405B Chat og dens effektivitet, giver denne tabel værdifuld indsigt i de grundlæggende benchmarks, der understøtter disse Lama-modeller.

| Kategori | Benchmark | #-skud | Metrisk | Llama 3 8B | Llama 3.1 8B | Llama 3 70B | Llama 3.1 70B | Llama 3.1 405B |

|---|---|---|---|---|---|---|---|---|

| Generelt | MMLU | 5 | macro_avg/acc_char | 66.7 | 66.7 | 79.5 | 79.3 | 85.2 |

| MMLU-Pro (CoT) | 5 | macro_avg/acc_char | 36.2 | 37.1 | 55.0 | 53.8 | 61.6 | |

| AGIEval engelsk | 3-5 | gennemsnit/acc_char | 47.1 | 47.8 | 63.0 | 64.6 | 71.6 | |

| CommonSenseQA | 7 | acc_char | 72.6 | 75.0 | 83.8 | 84.1 | 85.8 | |

| Winogrande | 5 | acc_char | – | 60.5 | – | 83.3 | 86.7 | |

| BIG-Bench Hard (CoT) | 3 | gennemsnit/em | 61.1 | 64.2 | 81.3 | 81.6 | 85.9 | |

| ARC-udfordring | 25 | acc_char | 79.4 | 79.7 | 93.1 | 92.9 | 96.1 | |

| Ræsonnement om viden | TriviaQA-Wiki | 5 | em | 78.5 | 77.6 | 89.7 | 89.8 | 91.8 |

| Læseforståelse | SQuAD | 1 | em | 76.4 | 77.0 | 85.6 | 81.8 | 89.3 |

| QuAC (F1) | 1 | f1 | 44.4 | 44.9 | 51.1 | 51.1 | 53.6 | |

| BoolQ | 0 | acc_char | 75.7 | 75.0 | 79.0 | 79.4 | 80.0 | |

| DROP (F1) | 3 | f1 | 58.4 | 59.5 | 79.7 | 79.6 | 84.8 |

Instruktionstunede modeller

Den Instruktionstunede modeller tabel giver et fokuseret kig på, hvordan Llama 3.1 modeller, især de Llama 3.1 405B, når de finjusteres til specifikke opgaver. Dette afsnit indeholder præstationsmålinger for opgaver, der følger instruktioner, kodeevaluering og ræsonnement, og fremhæver de forbedrede AI-muligheder opnået gennem instruktionstuning. Det er en vigtig ressource til at forstå model specifikationer der driver den online Llama 3.1 405B Chat's evne til at håndtere komplekse forespørgsler og opgaver. Denne tabel er uvurderlig for dem, der udvikler applikationer eller opretter Brugervejledninger der udnytter den Llama 3.1 modellernes avancerede evner.

| Kategori | Benchmark | #-skud | Metrisk | Llama 3 8B Instruktør | Llama 3.1 8B Instruktør | Llama 3 70B Instruktør | Llama 3.1 70B Instruer | Llama 3.1 405B Instruktion |

|---|---|---|---|---|---|---|---|---|

| Generelt | MMLU | 5 | makro_avg/acc | 68.5 | 69.4 | 82.0 | 83.6 | 87.3 |

| MMLU (CoT) | 0 | makro_avg/acc | 65.3 | 73.0 | 80.9 | 86.0 | 88.6 | |

| MMLU-Pro (CoT) | 5 | micro_avg/acc_char | 45.5 | 48.3 | 63.4 | 66.4 | 73.3 | |

| IFEval | – | – | 76.8 | 80.4 | 82.9 | 87.5 | 88.6 | |

| Ræsonnement | ARC-C | 0 | acc | 82.4 | 83.4 | 94.4 | 94.8 | 96.9 |

| GPQA | 0 | em | 34.6 | 30.4 | 39.5 | 41.7 | 50.7 | |

| Kode | HumanEval | 0 | pass@1 | 60.4 | 72.6 | 81.7 | 80.5 | 89.0 |

| MBPP ++ basisversion | 0 | pass@1 | 70.6 | 72.8 | 82.5 | 86.0 | 88.6 | |

| Multipl-E HumanEval | 0 | pass@1 | – | 50.8 | – | 65.5 | 75.2 | |

| Multipl-E MBPP | 0 | pass@1 | – | 52.4 | – | 62.0 | 65.7 | |

| Matematik | GSM-8K (CoT) | 8 | em_maj1@1 | 80.6 | 84.5 | 93.0 | 95.1 | 96.8 |

| MATH (CoT) | 0 | final_em | 29.1 | 51.9 | 51.0 | 68.0 | 73.8 | |

| Brug af værktøj | API-bank | 0 | acc | 48.3 | 82.6 | 85.1 | 90.0 | 92.0 |

| BFCL | 0 | acc | 60.3 | 76.1 | 83.0 | 84.8 | 88.5 | |

| Gorilla Benchmark API Bench | 0 | acc | 1.7 | 8.2 | 14.7 | 29.7 | 35.3 | |

| Nexus (0-skud) | 0 | makro_avg/acc | 18.1 | 38.5 | 47.8 | 56.7 | 58.7 | |

| Flersproget | Flersproget MGSM (CoT) | 0 | em | – | 68.9 | – | 86.9 | 91.6 |

Flersprogede benchmarks

Den Flersprogede benchmarks tabel viser resultaterne af Llama 3.1 modeller på forskellige sprog, herunder portugisisk, spansk, italiensk, tysk, fransk, hindi og thai. Dette afsnit illustrerer modellernes evne til at håndtere flersproget input og giver præstationsmålinger, der er specifikke for hvert sprog. For dem, der er interesserede i at implementere online Llama 3.1 405B Chat i forskellige sproglige kontekster, fremhæver denne tabel de AI-muligheder og Tekniske specifikationer der gør disse modeller alsidige på tværs af forskellige sprog. Det er en vigtig ressource til at forstå, hvor godt Lama-modeller optræde globalt Brugsscenarier og for at skabe effektive Brugervejledninger.

| Kategori | Benchmark | Sprog | Llama 3.1 8B | Llama 3.1 70B | Llama 3.1 405B |

|---|---|---|---|---|---|

| Generelt | MMLU (5-shot, macro_avg/acc) | Portugisisk | 62.12 | 80.13 | 84.95 |

| Spansk | 62.45 | 80.05 | 85.08 | ||

| Italiensk | 61.63 | 80.4 | 85.04 | ||

| Tysk | 60.59 | 79.27 | 84.36 | ||

| Fransk | 62.34 | 79.82 | 84.66 | ||

| Hindi | 50.88 | 74.52 | 80.31 | ||

| Thai | 50.32 | 72.95 | 78.21 |

Modellevalueringer med benchmarks